Особенности SEO-продвижения сайтов-агрегаторов

Агрегаторы хорошо ранжируются в поисковых системах и полезны для посетителей, так как охватывают множество запросов и имеют нужный функционал. Но чтобы занять первую страницу выдачи по коммерческим запросам, просто создать агрегатор – не достаточно. Ресурс нужно постоянно развивать, чтобы он закрывал как можно больше вопросов целевой аудитории. Ниже представлены ключевые моменты в продвижении агрегаторов, работа над которыми поможет сайту улучшить позиции в поиске.

Внутренняя оптимизация и структура

Сбор семантического ядра и составление структуры сайта желательно реализовать до запуска. Даже если запланированы разделы, которые по каким-то причинам пока не нужны, о них нужно знать заранее. Это будущие точки роста. Затем выполняется приоритизация разделов и итерационное внедрение.

Если сайт уже запущен, необходимо еще раз проработать структуру и провести приоритизацию. Первым делом внедряйте и расширяйте коммерческую семантику – категории товаров/услуг, посадочные страницы, прайсы.

Оптимизация заголовков и метатегов для агрегатора, особенно на первых этапах, реализуется по шаблону. Агрегаторы не нуждаются в проработке точных вхождений. Кроме того, такая работа трудозатратна по времени, поскольку товаров много, а частота по городам отличается.

Возьмите самую высокочастотную формулировку по кластеру одной услуги и реализуйте шаблонный title с распространением по всем услугам и применением переменных. Например, если сайт агрегирует автосервисы, содержит страницы услуг со списком автосервисов, оказывающих эти услуги, то основные переменные для страницы будут:

[услуга], [город] и ключи для коммерциализации «Цена», «Автосервисы».

По итогу шаблонный title будет выглядеть примерно так: «[услуга] в автосервисах [город] с адресами и ценами от [мин цена ] руб.». Пример с услугой «ремонт рулевой рейки»: «Ремонт рулевой рейки в автосервисах Москвы от 4500 руб.».

Не забывайте предусмотреть склоняемость всех ключей и текстовых элементов в метатегах и на странице.

По ходу продвижения и роста сайта можно выделять ресурсы на точечную проработку ключей в рамках гипотез.

Текст для агрегаторов – не основной контент. Главное – это ассортимент. Большая ошибка – писать SEO-текст с максимальным охватом ключей и размещать на первом экране в ущерб карточкам. При этом хорошо работает мини-текст «Генережка», который кратко характеризует содержимое страницы. Такой текст имеет объем 300-500 символов и содержит максимум переменных, например, краткую информацию о товаре на странице. Поисковые системы охотно берут такой сгенерированный текст в сниппет взамен Description.

Как итог – шаблонная оптимизация метатегов и уникальный текст в 300-500 символов с задействованием переменных. Для охвата точных вхождений фраз по кластерам можно усилить сайт текстами после основного контента.

Техническая оптимизация

Агрегаторы, как правило, имеют сложную структуру со множеством страниц и полезный функционал. Как следствие, могут появляться технические ошибки в процессе реализации и работы сайта. Этот аспект нужно брать на регулярной основе во внимание и проводить технический аудит не реже 1 раза в месяц.

Обязательно тщательное тестирование после каждого обновления сайта. К серьезным проблемам можно отнести появление дублей страниц, метатегов, удаление части контента на страницах и многое другое. Также при использовании фильтров на сайте могут генерироваться страницы, не предназначенные для попадания в индекс. Такие страницы можно закрывать в robots, meta noindex.

К критичным проблемам можно отнести слет оптимизации, когда множество списков приобретают одинаковый title. Подобные проблемы лучше править в короткие сроки. Не критично, если проблема актуальна в течение 1-2 дней. Поисковики делают поправку на возможность таких ошибок и не будут пессимизировать страницы.

Когда проблема актуальна продолжительное время, это может сказаться негативно на продвижении сайта. После возврата актуальных метатегов возможна переоценка, и страницы могут не сразу вернуться на прежние позиции. Обращайте внимание на числовые переменные и их соответствие на странице и в метаописании – количество организаций по заданному гео, минимальная цена или диапазон цены, количество отзывов, сроки доставки, реализации услуги, ответа оператора и т.д. Чекайте скорость загрузки важных страниц после каждого внедрения задач. Проверяйте вебмастера поисковых систем и файл robots.txt.

Контент и функционал

Как я упоминал выше, основной контент любого агрегатора – это карточки товара/организации/услуг, которые дают исчерпывающую информацию и закрывают вопросы посетителя, а также функционал, который помогает в выборе. В нашем примере с сайтом 32top.ru нишевым функционалом выступает онлайн-расписание врачей, которое позволяет записаться на определенную дату и время.

Чтобы выявить такой функционал и включить его на сайте, проводится аудит конкурентов. Помимо нишевого функционала, не лишним проработать и шаблонный. Например, применить добавление в избранное или опцию «к сравнению».

Контент на сайте должен обновляться регулярно. Еще до разработки нужно спланировать и организовать варианты добавления или изменения информации на сайте. Вносить изменения на сайт могут сотрудники. Также можно настроить автоматическую настройку обновлений с помощью парсеров или API-интеграций.

Отзывы о сайте и продукте

Работа с отзывами должна быть регулярной, так как они влияют на место в поиске. С 2022 года Яндекс повысил приоритет наличия/отсутствия отзывов в Яндекс Браузере и Яндекс Картах.

Это касается и отзывов о продуктах, которые вы агрегируете. Они дают и дополнительный охват конверсионных кластеров, и увеличивают общее время на сайте, и повышают вовлеченность. Конечно, отзывы должны быть естественными и отражать истинное мнение о продукте. Не всегда получается организовать сбор отзывов на сайте-агрегаторе, так как крючков для посетителей может быть недостаточно. Однако если вы найдете такой способ и сможете мотивировать писать отзывы, вы увеличите авторитет в глазах поисковых систем и аудитории. Также всегда есть менее эффективный вариант – аккуратно собирать отзывы на нескольких сторонних ресурсах.

Бренд и ссылочный профиль

Для построения грамотного ссылочного профиля рекомендуем аутрич и налаживание партнерских отношений с авторитетными сайтами, схожими по тематике с вашим агрегатором. Ссылок не обязательно должно быть много, но их плавный рост с качественных ресурсов в перспективе приведет сайт к успеху в Google.

Пропорции анкор/безанкор можно подсмотреть у конкурентов. Мы придерживаемся отношения 70% безанкорных и 30% качественных анкорных. Безанкорные добываются при помощи крауд-маркетинга + естественными постановками ссылок. Также рекомендуем уделять внимание социальным сигналам – коммуникации в лентах с тематическими аудиториями без простановки ссылок. Это особенно актуально на первых порах после запуска, когда компания неизвестна и о естественной активности не идет речи.

Коммерческие факторы

Речь идет не только о ценах или адресе. Тут мы подтверждаем официальное разрешение на ту или иную деятельность. Если это врач, то посадочная должна содержать сертификат об образовании. Если клиника – лицензию.

Заключение

Если вы хотите вывести агрегатор в топ Яндекса и Google, важно проводить работы комплексно. В основной список задач должны входить внутренняя и техническая оптимизация, контент и функционал, отзывы о сайте и продукте, внушительный ссылочный профиль с авторитетных сайтов. Такой комплекс мер неизбежно приводит к результатам.

|

Друзья, теперь вы можете поддержать SEOnews https://pay.cloudtips.ru/p/8828f772 Ваши донаты помогут нам развивать издание и дальше радовать вас полезным контентом. |

|

SEO продвижение сайтов агрегаторов и маркетплейсов

Для начала рассмотрим основные моменты, которые мешают сайту хорошо ранжироваться и получать трафик, а также где искать точки роста. Также узнаем, с чего начинается seo оптимизация маркетплейса или агрегатора.

Баги в технической оптимизации

Стоят на первом месте среди проблем, влияющих на рост трафика и индексацию. Их необходимо отслеживать после каждого релиза и вмешательства в систему.

Читайте материал на Коллабораторе о решении задач технической оптимизации сайтов (или смотрите вебинар).

Семантическая полнота проекта

Следующий важный момент — семантическая полнота. В собственных проектах проблемы семантической полноты могут никогда не возникнуть, но в некоторых клиентских проектах с ограниченным ассортиментом иногда приходится серьезно думать, за счет ее расширить. Задача расширения семантической полноты в том, чтобы семантика сайта охватывала максимум в своей нише, насколько только это возможно в рамках одного проекта.

Качество и релевантность контента

Важно также качество контента. В E-com речь прежде всего о карточках товара. На старте они часто представлены только изображением и ценой. Работы по формированию описаний дадут свою отдачу.

Заниматься нужно также релевантностью контента. На больших проектах это может быть шаблонной работой, которая приведет к повышению видимости в поисковиках и к росту трафика сайта.

YMYL и E-A-T

Важным фактором ранжирования является YMYL и E-A-T. Это активно внедряет Google и планирует Yandex. Работа в этом направлении тоже должна быть постоянной.

Ссылочное продвижение

В Яндексе часто связано с работой с ботами для поведенческих факторов. Несмотря на официальную позицию Яндекса о том, что активность ботов не влияет на ранжирование, по факту видим, что во многих проектах 90% активности составляют боты, а стратегия с одним только органическим трафиком проигрывает.

О ссылочном продвижении рассказывают все seo-эксперты. Можете посмотреть уроки по продвижению ссылкам на нашем seo-курсе для новичков и выбрать материалы в подборке SEO книг.

Как продвигать маркетплейс или сайт агрегатор

SEO продвижение маркетплейсов и агрегаторов включает такие работы:

- анализ собственного проекта. Детальный анализ проводится в самом начале, потом ежемесячно подводят промежуточные итоги;

- анализ конкурентов. Это базовый вид SEO-работы, который нужно проводить постоянно, поскольку конкуренты постоянно развиваются;

- составление гипотез;

- реализация своих идей;

- постаналитика выполненного;

- повторение этапов: Гипотеза – Реализация – Аналитика.

SEO-работы – итерационные. Итерации повторяются, SEO невозможно сделать один раз и забыть. Схематически seo оптимизация и продвижение маркетплейсов выглядит так:

Анализ собственной структуры и трафика включает следующие работы:

- определение типов страниц (карты трафика);

- определение количества документов в группах;

- определение суммарной частотности группы;

- определение количества документов с трафиком в группе;

- определение отношения Трафик/Документ.

Любой проект включает в себя страницы нескольких типов и каждый тип необходимо анализировать отдельно. По каждому типу страниц нужно построить карту трафика. Потом — выявить количество документов в группе, что подразумевает определение:

- количества категорий (это одна группа),

- брендов в категории (это еще одна группа),

- товаров в категории (еще одна группа, количество в которой нужно подсчитать).

Далее выясняем, какое количество посадочных страниц в каждой группе работает, а какое — нет. Это позволит понять, в каких группах во что именно вкладывать силы. Мы также должны понимать, какие документы лучше всего работают — дают больше трафика.

Сводная таблица структуры трафика

Мы обычно составляем сводную таблицу по трафику. Она имеет простую структуру и может быть разной в разных проектах. В таблицу выводится динамика трафика по каждой группе за последний год или за меньший период.

Мы также периодически анализируем, как работают документы в связи с их вложенностью. К примеру, определяем какой трафик дают первая, вторая и третья группы документов по вложенности, и делаем соответствующие выводы. В некоторых случаях уменьшение вложенности может дать определенный профит.

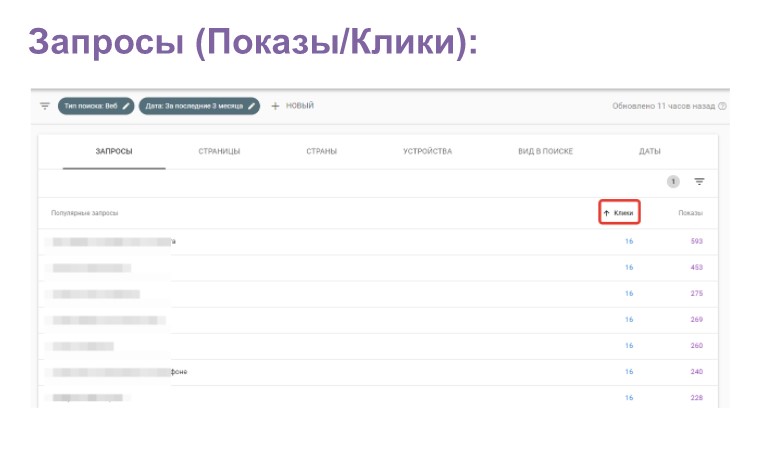

Анализ существующего спроса проекта

Существующий спрос проекта необходимо анализировать постоянно. Для этого мы используем различные сервисы аналитики:

- Статистика поисковых запросов — Популярные запросы (Яндекс.Вебмастер);

- Эффективность — Запросы Показы/Клики (SC);

- Потоки данных — Отслеживание — Поиск по сайту (Google Analytics);

- Стандартные отчеты — Содержание — Параметры в URI (Yandex.metrika);

- логирование запросов в форме поиска (sphinx | elastic);

- комбинации умного фильтра.

Собственный спрос в системах аналитики

Его невозможно найти в готовом виде. Собственный спрос включает то, что можно увидеть:

- в Яндекс.Мастере в панели «webmaster» (смотрим популярные запросы в отчете «Статистика поисковых запросов»);

- в «Google Search Console» (исследуем отчет «Эффективность»: запросы – показы/клики).

Таким образом можно узнать, по каким запросам были клики или по каким — нет.

Мы делаем выборку запросов, по которым было максимально показов, но не было кликов, отбираем также группы запросов, по которым не было показов, понимая, что над этим нужно поработать. На основе полученной информации устанавливаем приоритеты, определяя, в каких направлениях будем работать в ближайшее время.

Лонгирование запросов

Мы также используем логирование запросов в форме поиска сайта. Так иногда можно определить, что люди часто ищут неочевидные на первый взгляд вещи, используют запросы, которых нет в вордстате. Если спрос на такие запросы регулярный, имеет смысл рассмотреть целесообразность создания под эти запросы посадочных страниц. Подобные решения принимаются не на основе информации за один день, а за какой-то относительно длительный период. Если с определенной периодичностью разные люди ищут что-то, чего в структуре нет, стоит под такой запрос создать посадочные страницы и включить их в структуру сайта.

Анализ поиска может привести к повышению трафика для существующих групп товаров, а также для принятия решения о введении в продажу новых групп товаров либо введения на сайт новой группы контента. Часто люди ищут что-то, что на сайте есть, но не находят. Если искомое есть, мы группируем, организуя новые посадочные страницы, если нет — можно добавить. Таким образом анализ внутреннего спроса позволяет развивать проект.

Умный фильтр

Сейчас во многих cms используется «умный фильтр», который позволяет на основе выбираемых параметров формировать динамический URL — ЧПУ. Для нас все это может стать информацией о том, как по набору параметров формировать новые посадочные страницы, которые потом продвигать.

Для планирования развития структуры мы используем параметры URL в метрике. По параметрам ЧПУ можно понять, что люди чаще всего выбирали и посещали.

Например, если на сайте о недвижимости люди часто интересовались типом недвижимости и ценами, можно формировать страницы под типы недвижимости в каждом ценовом диапазоне и т.д.

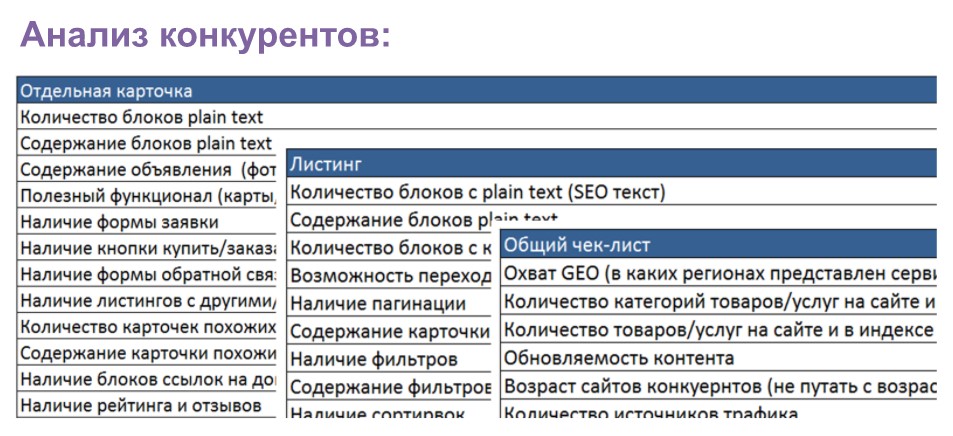

Анализ конкурентов

Анализ конкурентов — важная и постоянная часть работы SEO-специлиста. Обобщенно можно выделить такие направления:

- типы проектов;

- возраст конкурентов;

- типы посадочных страниц;

- структура сайта;

- количество документов в индексе;

- количество документов с трафиком;

- обновление контента;

- гео-структура;

- количество различных типов страниц на сайте;

- источники и прогнозируемый объем трафика;

- ссылочный профиль;

- страницы-лидеры по трафику.

Типы и возраст проектов

Мы всегда анализируем типы проектов конкурентов. Иногда приходят клиенты и спрашивают, что нужно поменять, а мы понимаем, что с данным типом проекта мы не преодолеем конкурентов. Если речь идет о каталоге товаров или организаций, мы смотрим, есть ли это на рынке. Если конкурентом будет слишком серьезный проект типа «Отзовик», нужно понимать свои силы.

Мы учитываем возраст конкурентов. Это не возраст домена. Чтобы узнать возраст конкурента, можно искать первое упоминание в «вебархиве», или задавать в поиске ограничение по датам, чтобы понять, какое количество страниц в искомом диапазоне дат было проиндексировано.

Типы посадочных страниц

Нужно изучать также типы посадочных страниц конкурентов. Мы изучаем, какую структуру имеют сайты конкурентов, какое у них количество документов в индексе. Правда Яндекс сейчас ограничивает вывод, в таком случае можно индексацию проверять перебором, устанавливая параметры для результата по каждому их них, потом объединив полученное количество результатов. Можно также использовать парсинг проекта с помощью различных сервисов.

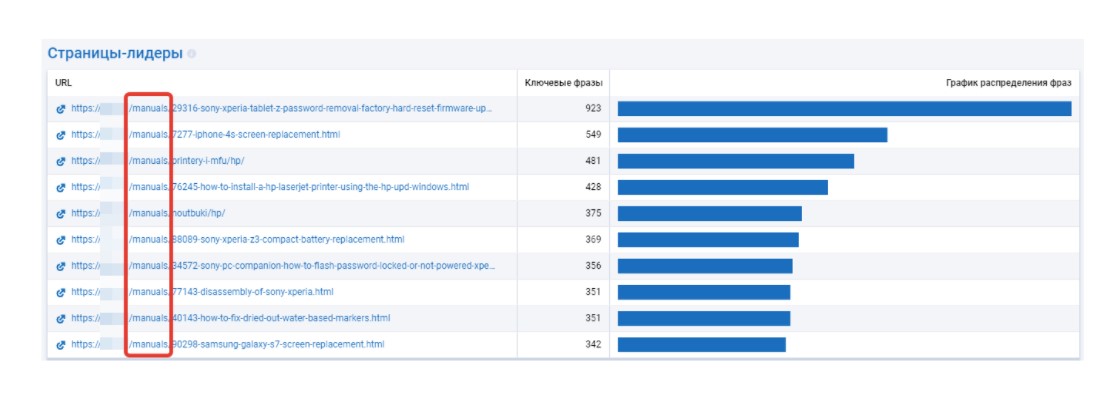

Количество документов с трафиком — эффективная метрика, позволяющая понять, что из общего объема документов в индексе дает трафик. В этом помогают публичные сервисы типа Serpstat и другие, которые предлагают информацию о самых популярных страницах.

Контент и Гео

Важно также изучать обновляемость контента. В поисковиках можно ограничивать период, чтобы увидеть, какое количество документов обновляется в определенные периоды.

Стоит также учитывать домены, поддомены, директории сайта конкурента, определять, как у конкурентов организована гео-структура.

Смотрим количество разных типов страниц, анализируем контент на популярных страницах.

Источники и прогнозируемый объем трафика

Если мы работаем с SEO, нам важно понимать, какие основные источники трафика у конкурентов. Иногда целесообразен платный трафик, если видим, что у конкурентов это работает и мы вступаем с ними в борьбу.

Важно определить прогнозируемый объем трафика конкурентов – это ниша для анализа, позволяющая учитывать относительные значения, чтобы понимать, к чему можно стремиться.

Иногда у нас есть ожидания, к примеру, собрать «миллион трафика», но мы видим, что в данной нише даже лучшие конкуренты не собирают такой трафик при таком же типе проекта. Имея такую информацию, нужно либо делать выводы о нереальных целях, либо продумывать, что новое можно развить для достижения цели.

Ссылочный профиль

Его важно анализировать, чтобы понять, что дает трафик конкурентам. Иногда изучаешь страницы-лидеры и понимаешь, что трафик им дает не то, что нужно бы. К примеру, у нас проект-справочник, а основной трафик – на информационный раздел.

Базовый анализ конкурентов

Базовый анализ конкурентов мы собираем в таблицу, которая включает информацию об отдельных карточках (количество блоков, содержание блоков, полезный функционал, наличие формы заявки, формы Купить и пр.), о листинге (наличие фильтров, пагинации, количество блоков и пр.) и общий чек-лист (в каких регионах представлен, количество категорий, товаров, обновляемость контента и пр.).

Таблица анализа может отличаться от проекта к проекту.

Дополнительные ссылки для анализа сайтов конкурентов

- полное руководство, как сделать анализ сайтов конкурентов (инструментарий, возможности);

- как проверить обратные ссылки на сайт: инструменты для анализа внешних ссылок сайта;

- как проверить посещаемость любого сайта: бесплатные и платные инструменты для анализа трафика сайта;

- как определить траст сайта;

- как узнать, на каком движке сайт: 10+ способов проверки CMS любого сайта.

За счет чего можно расти агрегатору

SEO для маркетплейсов и агрегаторов частично совпадает с классическим продвижением интернет-магазина. Но не все таке просто. Есть несколько направлений для роста проекта.

Новый и старый контент на сайте

Если текущий контент и сайт совсем плохие, нужно сначала заняться этим, привести все в порядок. Однако, исходя из опыта, старый контент растет очень медленно, даже если дорабатывать его. Хороший прирост трафика дает новый контент и создание новых посадочных страниц.

Работа со старым контентом — один из факторов роста. Что делать со старым контентом? Он подлежит актуализации, обогащению данными, YMYL и E-A-T, внедрению шаблонов.

Тегирование в листингах

Расти можно за счет шаблонного тегирования в листингах. Если говорить о товарах, не нужно собирать никакую семантику, чтобы добавить листинг по цене Недорого/Дешево. Если у вас тысяча страниц, получите плюс тысячу страниц «купить диван недорого».

Самое главное в seo для маркетплейса: при создании листингов обращайте внимание на то, чтобы не получались дубли: если у вас в категории всего 5 товаров, то и на родительском листинге будет 5 товаров, и на новом — те же 5.

То есть идея подходит для больших листингов. Для справочников для создания нового листинга можно использовать параметры «Открыто сейчас», «Круглосуточно», для продуктов — листинг по цене.

Классическая зона роста — теги по новой семантике. Смотрим, чего у нас нет, и формируем новые посадочные страницы.

Бездумно посадочные страницы создавать не стоит, поскольку по большой части семантики могут получиться маленькие листинги по несколько товаров. Учитывая это, при формировании посадочных страниц добавляем условие по количеству блоков товаров не менее установленного числа, например, не менее 10-15 товаров. Учитывается также частотность по тем или иным группам товаров. Иначе получим много страниц с нулевой частотностью, что снижает SEO-привлекательность. Мы сначала получаем ЧПУ по параметрам фильтров, отправляем все такие страницы в базу и анализируем на частотность, после чего принимает решение об их публикации.

Новые типы посадочных страниц

Можно создавать новые типы посадочных страниц. Анализируя страницы товаров, можно, например, отобрать товары категории с наибольшим количеством отзывом и создать новый тип посадочной страницы «категория/отзывы». К примеру, создаем страницу «диваны_красного_цвета/отзывы» и генерируем на эту страницу превью всех отзывов о такой категории продукции.

Такой тип посадочных страниц неплохо конвертируется, поскольку люди часто ищут отзывы о товарах, прежде чем принять решение о покупке.

Рассматривайте варианты внедрения новых разделов, например «Часто задаваемые вопросы», обзоры, мануалы. Под обзорами подразумевается информация из разряда «Топ-10». Торгуете чайниками — пусть там появятся топ-10 чайников разных типов со ссылками на карточки товаров, где их можно приобрести. Анализ сайтов конкурентов и поиск разделов, которые собирают больше всего трафика – это источник новых идей для использования у себя.

Например, если зайти на аналитику конкурента в сервисе Serpstat и изучить отчет «Страницы-лидеры», можно сделать выводы о том, что чаще посещает ваша потенциальная аудитория, и создать на своем сайте такие же страницы и разделы.

Расширяем ГЕО и делаем новый функционал

Изменения в геоструктуре сайта иногда помогают в продвижении, решения об этом принимаются на основе анализа конкурентов. При таких изменениях весь сайт будет индексироваться заново, что иногда полезно.

Стоит обратить внимание и на внедрение полезного функционала на сайт — виджеты, калькуляторы, полезные аналитические данные в виде удобных виджетов.

Анализировать конкурентов очень полезно, поскольку мы смотрим, за счет чего они раскручиваются, чем привлекают аудиторию, и какие идеи можно позаимствовать у них.

Где брать контент для агрегаторов, когда его нет?

Копирайтинг — идеально, но часто это долго и дорого. Если необходимо, приходится писать свои тексты, но есть и другие способы наполнения сайта контентом.

На многих проектах нет полей для комментариев и отзывов, однако UGC-контент важен с точки зрения авторитетности и качества проекта. Кроме этого, из отзывов и пользовательских обзоров можно формировать посадочные страницы типа «Комментарии и отзывы категории».

Можно использовать готовые базы товаров с характеристиками. Это проще, чем изначально формировать собственный каталог. Можно заполнить характеристики самостоятельно только для самых важных товаров. Характеристики важны, поскольку без них невозможно полноценно выполнить тегирование и использовать другие возможности SEO.

Шаблонный текст и компиляция — оптимальный вариант, который работает и в Яндексе, и в Google. Правда, тут важен вопрос исполнения.

Под шаблонный текст создаются маски: если запускается крупный проект, в котором изначально несколько тысяч страниц, то это возможность получить контент быстро и адекватно по стоимости.

Написать более 5 тысяч страниц — это дорого и нецелесообразно. Маска делается под каждый тип страниц, или несколько масок под каждый тип страниц, и автоматически подставляются заменяемые параметры. Это позволяет запустить сайт сразу с контентом, после чего можно следить за уникальностью масок относительно друг друга.

Компиляция. Здесь может быть компиляция обычного текста или характеристик, свойств, отзывов и т.д. В Яндексе и в Google это работает.

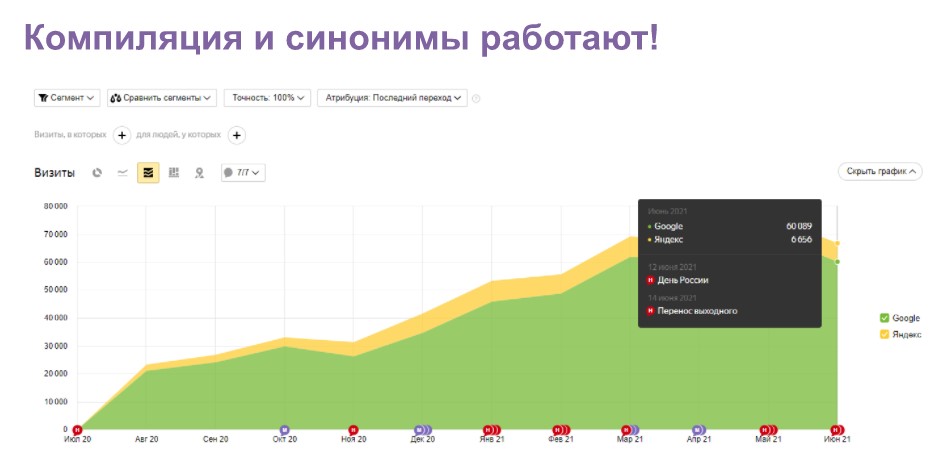

У нас есть пример проекта на UGC-контенте: проект собирал информацию из около 10 источников и применял синонимизацию с учетом биграмм и триграмм. Из 30 тысяч блоков контента мы выстроили словарь биграмм и триграмм, которые применяли в синонимизации. В таких задачах очень важно следить за качеством и не применять все сразу, тестировать по несколько страниц прежде чем масштабировать.

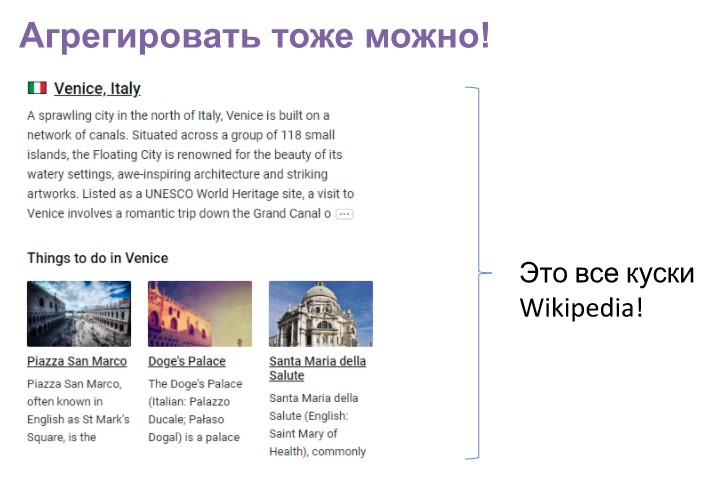

Можно использовать агрегацию и строить на ней целые проекты. Есть примеры проектов, использующих Википедию с очищенным от ссылок и подготовленным под проект контентом.

Один такой проект, который построен на скомпилированном контенте и на смарт-шаблонах, собирает больше десятка миллионов трафика в месяц.

У конкурентов можно брать идеи для создания на основе агрегации своих страниц, разделов, проектов.

Что делать с YMYL/EAT для агрегаторов и маркетплейсов

Если вы доска объявлений или агрегатор товаров, то не будете помечены поисковиком как интернет-магазин. Важно максимально мимикрировать. Можно эмулировать корзину, размещать блоки, характерные для магазина. Старайтесь стать максимально похожими на магазин.

Как повысить индексацию

Нет индексации — нет и трафика. Что делать?

Внутренние ссылки и перелинковка

Работаем над внутренней ссылочной структурой сайта — повышаем количество внутренних ссылок.

На каждую важную страницу должно быть не менее 3-5 внутренних ссылок.

Не должно быть такого, чтобы страница была, а ссылки на нее в структуре не было.

Перелинковка может быть статичная. Мы практикуем приоритетную перелинковку: выгружаем все категории, подкатегории и теги, снимаем частотность и получаем некий рейтинг. Соответственно в статике мы используем приоритетные для нас категории. Делаем также рандомный блок со ссылками, а также готовим блоки для ботов поисковой системы.

Дополнительно можно в фильтрах установить, чтобы после того как человек выбирает в фильтрах параметры, его отправляло на сформированную страницу – это повысит ее посещаемость. Так мы увеличим количество страниц, доступных для индексации.

Можно создавать хабовые страницы для различных их типов, на них можно будет проставлять ссылки, можно даже безанкорные, для того чтобы страницы из этой группы быстрее заходили в индекс.

HTML карта сайта может представлять собой алфавитный каталог всего, что у вас на сайте есть. Если очень много страниц, каждый раз этот список может быть рандомным. Например, если мы ищем варианты, куда поехать, можем получать каждый раз рандомный список городов. Это будет повышать индексацию.

Какие инструменты использовать для продвижения маркетплейсов

Для продвижения агрегаторов и маркетплейсов мы используем различные инструменты:

- a-parser;

- Netpeak Spider;

- Netpeak Checker;

- KeyAssort;

- Serpstat;

- keys.so;

- Google Search Console;

- search.google.com;

- analytics.google.com;

- Яндекс.Вебмастер;

- Яндекс.Метрика;

- Вебмастер Bing.

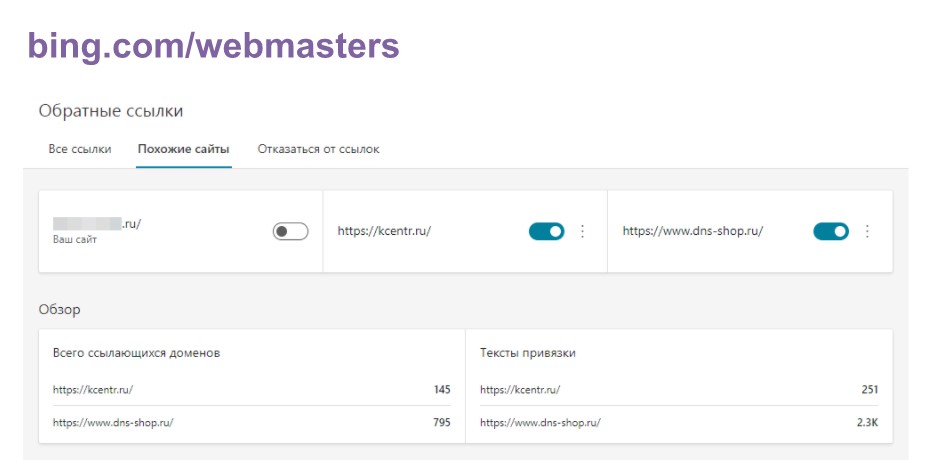

Сервис bing.com/webmasters мало кто использует. Но там есть интересные возможности, которые позволяют получить информацию по своему сайту и сайтам конкурентов: ссылающиеся домены и тексты-привязки.

Так можно найти доноров, которые используют конкуренты. Инструмент бесплатный.

Сессия Вопрос-Ответ

Как вы поступаете с малополезными страницами на больших проектах? Как уникализировать карточки, чтобы Яндекс не выкидывал их пачками из индекса?

– Мы стараемся максимально увеличить качество посадочных страниц. Если страницы явно архивные, мы убираем их из индекса, ставим meta name nofollow, оставляя их для ссылочной индексации. Если карточки дают трафик, мы делаем блок перелинковки. Что касается выкидывания из индекса, здесь нужно разве что обогащение карточки товара контентом либо из других ресурсов, либо внутренними блоками с переменными об этом товаре. Надо пробовать разные варианты. Для очень больших проектов я не видел, чтобы страницы выкидывали из индекса, скорее всего такое бывает с новыми маленькими проектами.

Интересует влияние сквозных блоков с одинаковым содержимым на разных страницах сайта. По сути, это дублирующийся контент. Какое влияние он оказывает на позиции сайта? Например, у нас блоки сделаны в виде вкладок, при нажатии на которые контент раскрывается. Сделаны эти вкладки для людей, содержат полезную информацию, но дублируются на всех страницах сайта и карточках товара, а это тысячи страниц. Как это влияет на сайт? Если негативно, как рекомендуете исправить данную ситуацию?

– Узнать, влияет ли такой контент на позиции сайта, можно только проверив. Можно выводить через аякс, чтобы блоки не индексировались. Ява-скриптом прятать блоки не получится, потому что они все равно попадают в индекс. Можно взять одну группу страниц и спрятать на них эти блоки, и проследить, насколько изменятся позиции этих страниц. Чтобы дать совет более предметно, нужно знать, как устроена посадочная страница. Может быть влияние блока 5%, а может 90%, в разных ситуациях нужно действовать по-разному.

Стоит ли подключать Google-Indexing-Api для быстрой индексации страниц в Google?

– Любые инструменты хороши, если они работают. Мы для ускорения индексирования стараемся делать максимальное количество хабовых страниц и просто вручную отдаем на индексацию и переиндексацию эти страницы.

Какие возможны способы уникализации страниц тегов в интернет-магазине, когда в целом ассортимент от тега к тегу не сильно отличается, но кластеризация говорит о том, что нужны разные листинги?

– Поможет использование дополнительных сортировок в листинге. Таким образом мы один и тот же листинг дополнительно сортируем. Если в листинге не одна страница, когда есть пагинация, то это сделать проще. Если одна — нужно вытягивать контентом, использовать маски. Проблема может быть в том, что изначально мало страниц. Если у вас одна страница и на ней пять товаров, а вы делаете такую же с теми же пятью товарами, здесь уже нужно добавлять текст: только таким образом удастся уникализировать страницы.

Настраивали ли вы кеширование заголовков, каких именно и каков результат?

– Мы кешируем весь сайт постоянно. У нас практически весь контент кеширован, если он не обновляется. Это делается для ускорения, потому что у нас крупные проекты, к которым большое количество запросов постоянно, и страницы тяжелые: могут включать и рандомные ссылки, и отзывы и так далее.

Как работать с мультирегиональностью? Папки иди поддомены? Как при этом угодить и Яндексу, и Гуглу?

– Для Google предпочтительнее директории, для Яндекса — поддомены. Нужно смотреть по топам. Выгружаем свою семантику, выгружаем топы и смотрим, как сформированы их посадочные страницы в части гео. Если большинство выполнены на поддоменах — делаем поддомены, и наоборот. Только через анализ.

Расскажите о вашей системе обнаружения факапов на больших проектах. Какие аллерты настраиваете, какие дашборды, что мониторите?

– У нас настроен пинг на все типы страниц. Например, есть сайт с миллионом страниц. Это пять или пусть двадцать типов страниц. Мы пингуем каждый тип страниц раз в 30 минут. Если появляется ошибка — падает вся группа, и мы понимаем, что нужно с этим разбираться. Кроме того, отслеживаем классические уведомления от Яндекс о проблемах на сайте, а также серверные логи — мы их выгружаем и проверяем, какие есть ошибки. Можно также проверять, на месте ли фрагменты того или иного кода на странице. Кроме этого, после каждого релиза мы проводим технический аудит сайта, а также раз в месяц проверяем сайт на системные ошибки. На больших проектах чаще всего встречаются системные ошибки: если появляется одна ошибка — она повторится во всей группе документов.

Что скажете о текстах в интернет-магазинах? Важны ли они сейчас в категориях, нужны ли описания в карточках, используете ли автогенерируемые тексты либо каждый пишете вручную?

– Маски и шаблоны мы в любом случае используем. В листинге пусть даже коротенький текст на 300 символов должен быть, в карточке товара если нет уникального описания, его можно сгенерировать. Что касается того, нужны ли тексты в листингах и товарах, можно сделать выводы только по результатам анализа выдачи. Для некоторых ниш уникальный контент на таких страницах обязателен, для некоторых вообще не нужен, для некоторых достаточно одного только листинга, а карточки просто в списке.

Часто важно, чтобы было достаточное количество карточек. Если у конкурентов 30-40 карточек на странице, чтобы конкурировать, у нас должно быть такое же количество, не может быть меньше.

Что посоветуете для монобрендовых магазинов и производителей, у которых небольшие листинги? Как можно искусственно увеличить размер листинга?

– Искусственно увеличивать листинги, которых по сути нет и которые не отвечают спросу, не стоит. Они будут формировать отказы. Лучше раскручивать свой бренд. Можно использовать другие каналы. Сейчас очень много каналов, через которые можно продавать свой товар. Не всегда SEO может помочь. Иногда приходят люди и говорят, что у них небольшой ассортимент, допустим, 100 платьев, а хотят, чтобы по запросу «купить платье» сайт был в топе. Через SEO по сути тут выйти в топ невозможно. Но можно попробовать поработать с поведенческими факторами.

Если нет реальных отзывов и рейтинга, используете ли вы заказные отзывы или пишете ли их сами?

– Можно заказывать отзывы, обзоры. Если заказывать отзывы не совсем корректно, то обзоры вполне нормальная практика. Можно пробовать агрегировать отзывы, но нужно тестировать и смотреть, подойдет ли это на вашем конкретном проекте. Может быть, что на одном получилось агрегировать и отзывы начали ранжироваться, а на другом сколько бы их ни было — не ранжируются.

Некоторые сервисы берут отзывы с маркета и выводят их как виджеты на сайт. Получается, что пользователь видит пусть отзывы не на конкретный товар из этого сайта, но все же на этот товар, а это дополнительная польза для посетителя.

Проводите ли вы SEO А/Б тесты?

– Да. Мы фиксируем группу страниц и применяем для них некоторые новые идеи. Мы применяем определенную правку на отдельной группе и наблюдаем за этой группой. Если с группой происходят положительные изменения, клонируем изменения на все остальные разделы сайта, если нет — не используем изменение.

Клиенту нравится запрос, но он нулевой. Выкинуть его не дают. Можно ли запрос приклеить, или такие запросы лучше выкидывать?

– Нужно смотреть, где нулевой, по вордстату? Бывает, что на сайт приходят по запросам, которые в вордстате показывают «0». Нужно ли его оставлять в отчете — дело ваше.

Занимаюсь маркет-плейсом в сфере услуг. Какие рекомендации по повышению локального трафика из Гугл в сфере услуг?

– Гугл позволяет подвязывать директорию под определенную локацию, это можно использовать.

На каких cms рекомендуете создавать крупные проекты?

– Я думаю, что лучше брать framework и на нем собирать, поскольку любой крупный проект — это кастомное решение, а не классический набор инструментов того же Битрикса, который крайне тяжелый и крайне дорогой. Если есть разработчик, можно брать связку Laravel/Yii. Если маленький проект, можно взять любую cms. Не обязательно строить сразу целый город, можно построить маленький домик и посмотреть, как пойдет. Можно сделать несколько мелких проектов в рамках одной ниши, чтобы выбрать лучшее решение, а другие использовать, как сателлиты.

Когда будете понимать, что этот проект уже можно масштабировать, лучше всего брать framework и на нем разворачивать. Сразу framework — это долго, дорого, и не всегда гарантирует успех.

Будет ли проблема, если одна компания создаст несколько сайтов?

Это зависит от ниши, но подобных проблем я не встречал.

Как проверить краулинговый бюджет?

– Мы смотрим данные вебмастера, сколько документов попало в обход за определенный период. Или можно использовать внутренние сервисы, логирование, которое может показать куда и как часто ходит поисковый бот.

Стоит ли для агрегатора товаров строить турбостраницы, не будет ли уходить туда трафика и что будет с конверсиями?

– У нас был опыт клиента, правда не агрегатора, когда турбостраницы снизили конверсию. Стоит тестировать, не применять сразу на всех группах товаров.

На старте для маркетплейса с учетом локальной выдачи генерируется порядка миллиона страниц. Как выкатывать, сразу всю структуру или начать с одной категории, а затем планомерно и ежедневно наращивать количество категорий в зависимости от скорости индексации?

– С одной категории я бы не стал начинать, лучше все, но по чуть-чуть. Можно начать с самых высокочастотных подкатегорий. Они бы зашли в индекс по структуре. Я стараюсь добавлять по +30% от того, что уже в индексе.

Если сайт доступен для индексации, есть sitemap, но не весь индексируется, это означает недостаток контента или в чем может быть причина?

– Причина может быть в качестве контента. У нас был такой проект, часть проиндексирована, остальное известно роботу, но не в индексе. Мы делали итерации с правками и через время страницы попали в индекс. В Гугл бывает, что большой sitemap не срабатывает, а если дробить его на части и «скармливать» маленькими sitemap, то процесс идет лучше.

Сначала стоит оценить документы, насколько они качественные, стоит также подождать, возможно, им нужно время, чтобы попасть в индекс.

Как относитесь к дропам? На больших проектах есть возможность приклеить множество доменов под Яндекс.

– По дропам ситуация следующая: вы либо подклеиваете его, либо разворачиваете дропом, он отстаивается и на нем делаете. Как я к этому отношусь? Я считаю, что вполне приемлемо покупать проект с историей в индексе, и который оттуда не выпадал.

Источник https://www.seonews.ru/analytics/osobennosti-seo-prodvizheniya-saytov-agregatorov/

Источник https://collaborator.pro/ru/blog/seo-marketplaces