Как оставаться в ТОПе при изменениях поисковых алгоритмов (руководство для начинающих сеошников)

После каждого обновления алгоритма поисковых систем часть SEO-оптимизаторов говорит, что оно было неудачным. Существует более 200 факторов ранжирования сайтов. Разумно предположить, что и возможных обновлений достаточно много. В этой статье мы расскажем, как работают поисковые алгоритмы, почему они постоянно меняются и как на это реагировать.

Что такое поисковые алгоритмы?

В их основе — формулы, которые определяют положение сайта в результатах поиска по определенному запросу. Они направлены на отбор веб-страниц, наиболее точно соответствующих введенной пользователем фразе. При этом они стараются не брать в расчет нерелевантные сайты и те, которые используют различные виды спама.

Поисковые системы смотрят на тексты сайта, в частности, на наличие в них ключевых слов. Контент — один из наиболее важных факторов при принятии решения о положении сайта в рейтинге. У Яндекса и Google разные алгоритмы, а потому результаты поисковой выдачи по одной и той же фразе у них могут отличаться. И все же основные правила ранжирования, заложенные в алгоритм, у них одинаковы. Например, они оба следят за оригинальностью контента.

Изначально, когда в Интернете было зарегистрировано мало сайтов, поисковики учитывали совсем небольшое количество параметров: заголовки, ключевые слова, размер текстов и др. Но вскоре владельцы веб-ресурсов стали активно использовать недобросовестные методы продвижения. Это и заставило поисковики развивать алгоритмы в сторону отслеживания спама. В результате сейчас часто именно спамеры с их все новыми и новыми методами диктуют тенденции развития поисковых алгоритмов.

Основная сложность в SEO-оптимизации сайта состоит в том, что Яндекс и Google не говорят о принципах их работы. Таким образом мы имеем лишь примерное представление о параметрах, которые они учитывают. Эти сведения основаны на выводах SEO-специалистов, постоянно пытающихся определить, что же влияет на рейтинг сайтов.

Например, стало известно, что поисковики определяют наиболее посещаемые страницы сайта и подсчитывают время, которое люди проводят на них. Системы исходят из того, что если пользователь находится на странице долго, то опубликованная информация полезна для него.

Сравнение алгоритмов Google и Яндекс

Алгоритмы Google первыми стали учитывать количество ссылок на других ресурсах, ведущих на определенный сайт. Нововведение позволило использовать естественное развитие Интернета для определения качества сайтов и их релевантности. Это было одной из причин, почему Google стал самым популярным поисковиком в мире.

Далее он стал учитывать актуальность информации и ее отношение к определенному местоположению. С 2001 года система научилась отличать информационные сайты от продающих. Тогда же она стала придавать большее значение ссылкам, размещенным на более качественных и популярных ресурсах.

В 2003 году Google начал обращать внимание на слишком частое употребление в текстах ключевых фраз. Данное нововведение значительно усложнило работу SEO-оптимизаторов и заставило их искать новые методы продвижения.

Вскоре Google стал учитывать и качество ранжируемых сайтов.

Яндекс рассказывает о принципе работы своих алгоритмов больше, чем Google. С 2007 года он стал публиковать информацию об изменениях в своем блоге.

Например, в 2008 году компания сообщила о том, что поисковик стал понимать сокращения и научился переводить слова в запросе. Тогда же Яндекс начал работу с иностранными ресурсами, в результате чего русскоязычным сайтам стало сложнее занимать высокие позиции по запросам с иностранными словами.

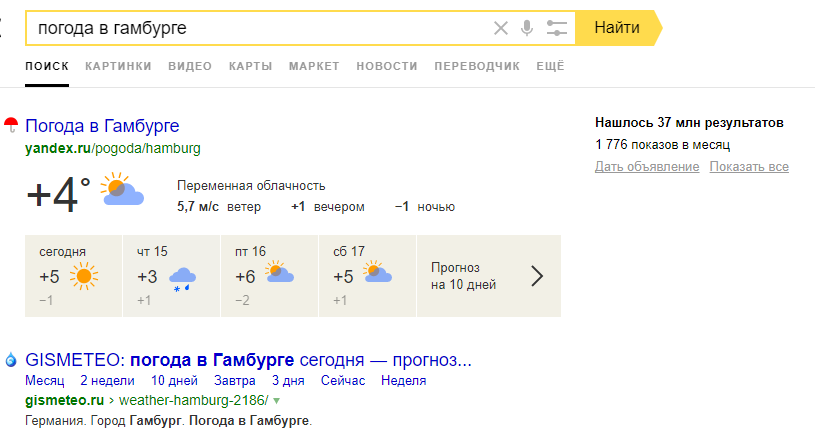

В том же году ответы на некоторые запросы пользователи начали получать прямо на страницах с результатами. Например, чтобы узнать погоду, не обязательно стало переходить на сайт.

Яндекс обратил внимание и на оригинальность текстов.

Далее поисковик начал более качественно обрабатывать запросы с минус-словами, понимать, когда пользователь допустил грамматическую ошибку. Кроме того, SEO-специалисты сделали вывод, что Яндекс стал отдавать предпочтение более старым сайтам, поднимая их рейтинг.

Виды изменений в алгоритмах

В большинстве случаев, когда мы говорим об обновлениях, то имеем в виду изменения в основном алгоритме поисковика. Он состоит из традиционных факторов ранжирования, а также алгоритмов, предназначенных для отслеживания и удаления спама.

Поэтому, когда происходит изменение алгоритма, а такое случается почти ежедневно, поисковик может вносить сразу много коррективов. А они способны серьезно повлиять на рейтинг вашего сайта на странице выдачи.

Обновления Google призваны помочь пользователям. Однако это не значит, что они помогают владельцам сайтов.

Существует два вида обновлений. Одни — касаются UX, то есть удобства пользования сайтом: реклама, всплывающие окна, скорость загрузки и т. д. Сюда относятся, например, обновления о ловле спама и оценке удобства использования мобильной версии сайта.

Другие обновления необходимы для оценки контента сайта: насколько он ценен для пользователя. Низкокачественный контент имеет следующие признаки:

- Один и тот же текст повторяется несколько раз на странице.

- Не помогает пользователю найти ответ на запрос.

- Обманным образом склоняет посетителя сайта купить товар.

- Часто содержит неправдивую информацию.

- Не является достоверным.

- Отсутствует ясная структура: выделение разделов и абзацев.

- Содержание не соответствует интересам целевой аудитории сайта.

- У него низкая уникальность.

Требования к сайтам довольно обширны, что и вызывает недовольство SEO-оптимизаторов. Некоторые считают, что Google отстаивает власть своего бренда и предвзято относится к небольшим сайтам.

Как воспринимать обновления поисковиков?

Для начала определите, способствуют они повышению или понижению вашего рейтинга. Если рейтинг упал, это не могло произойти просто так: значит что-то сделано неправильно.

Многие алгоритмы направлены на отслеживание спама. И все же возможно, что сайт теряет позиции, при этом не делая ничего плохого. Тогда причина обычно заключается в смене критериев отбора сайтов для ТОПа. Другими словами, вместо понижения рейтинга сайта за какие-то ошибки алгоритм может продвигать другие ресурсы, которые делают что-то лучше.

Следовательно, вам необходимо постоянно анализировать, почему сайты обходят вас. Например, если пользователь вводит информационный запрос, а ваш сайт является коммерческим, то страница с информационным контентом будет стоять выше вашего сайта.

Вот некоторые причины, почему конкуренты могут обгонять вас:

- Более точное соответствие запросу пользователя.

- Большое количество ссылок на данную страницу, размещенных на других ресурсах.

- Недавнее обновление страницы, в результате чего она стала более актуальной и ценной.

В других случаях понижение рейтинга может быть связано с введением нового фактора ранжирования. Важно знать разницу между нововведениями, которые способствуют продвижению других страниц, и нововведениями, которые ведут к потере позиций вашего сайта. Возможно, ваша стратегия SEO-продвижения нуждается в обновлении.

Ошибаются ли поисковые алгоритмы?

Да, иногда алгоритм срабатывает неправильно. Но это случается очень редко.

Ошибки алгоритмов обычно видны в длинных поисковых запросах. Изучите их результаты, чтобы лучше понять нововведения в алгоритме. Ошибкой можно считать случаи, когда страница с результатами явно не соответствует запросу.

Конечно, сначала вам придет в голову наиболее очевидное объяснение, но оно не всегда верно. Если вы решили, что поисковик отдает предпочтение определенным брендам или проблема заключается исключительно в UX сайта, то копните немного глубже. Возможно, вы найдете объяснение получше.

Как не зависеть от изменений алгоритмов?

Не так-то просто разобраться в принципах работы алгоритмов, а для отслеживания их изменений надо быть постоянно включенным в информационное поле. Однако не каждая компания имеет специалиста по SEO, часто задача продвижения в поисковиках отдается на фриланс. Тогда необходимо настроить SEO таким образом, чтобы позиция сайта оставалась стабильно высокой независимо от нововведений поисковиков.

Вот несколько способов сделать это.

1. Грамотно используйте продвижение с помощью ссылок.

Основная цель нововведений Яндекса и Google — это защита от спама. Например, раньше SEO-алгоритмы поднимали выше сайты, на которые было больше всего ссылок на других веб-страницах. В результате появился такой вид спама, как комментирование блогов. Фейковые записи обычно начинаются с нелепого штампового приветствия вроде “Какой прекрасный и познавательный у тебя блог” и заканчиваются ссылкой на страницу, содержание которой никак не соотносится с этим блогом.

В итоге поисковики стали активно вводить факторы ранжирования, позволяющие учитывать этот вид спама. Теперь ссылки на ваш сайт по-прежнему важны, но явно неестественные комментарии могут повредить вашему SEO-продвижению.

2. Взаимодействуйте с аудиторией.

Общение с потенциальными покупателями не только поможет вашему SEO, но и напрямую повысит продажи. Под взаимодействием подразумевается реклама, PR, SMM и другие способы “зацепить” пользователей в Интернете.

Естественное распространение информации о вашем бренде ведет к росту ссылок и переходов на ваш сайт. Таким образом, используя разные методы продвижения вы выигрываете дважды: с точки зрения SEO и прямых продаж.

3. Четко определите цели своего SEO.

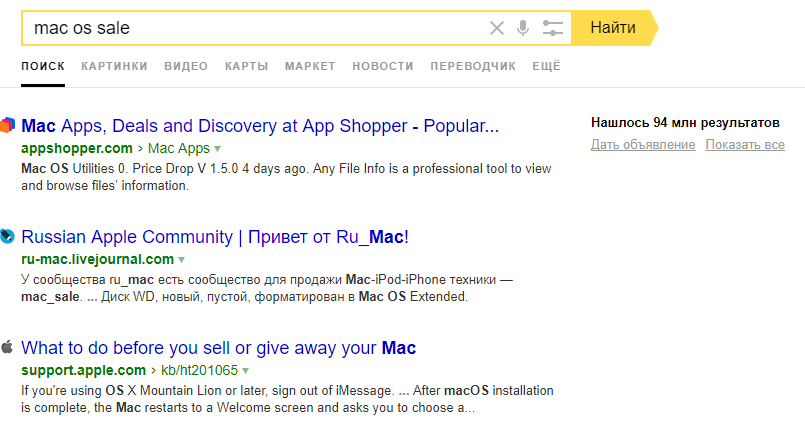

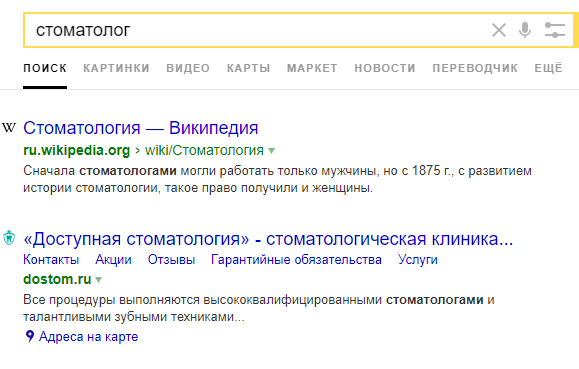

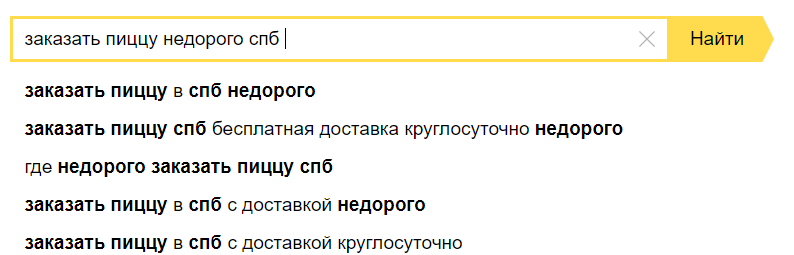

Часто представители компаний считают, что продвижение в поисковиках нужно для того, чтобы занимать высокие позиции по запросам из одного слова, вроде “адвокат”, “стоматология”, “суши”. Однако это не так. Пользователи все чаще вводят длинные поисковые фразы, например: “недорогая кофейня в самаре”. К тому же, поисковики выдают подсказки, которые могут сделать итоговый запрос еще длиннее.

Важно занимать высокие позиции именно по таким узким низко- и среднечастотным запросам.

Частые ошибки в SEO

Основной принцип работы с SEO, на которое не повлияют изменения алгоритмов, в том, чтобы ориентироваться не на увеличение количества переходов на сайт, а на привлечение реальных клиентов. Именно поэтому развитие SEO не должно сводиться к одним лишь кнопкам и текстам, написанным специально под алгоритмы. Конечно, без этого нельзя обойтись, однако такие элементы бессмысленны, если они не приводят покупателей.

SEO-оптимизаторы должны не только подбирать ключевые фразы для каждой отдельной страницы сайта и учитывать подсказки, которые предлагает пользователям поисковик, но и понимать конкурентные преимущества компании, которые необходимо использовать при конструировании и наполнении сайта.

Одной из популярных ошибок, которую допускают SEO-специалисты является подбор ключевых слов вручную, без использования специальных программ. В результате они пропускают некоторые ценные запросы и, в то же время, оставляют неэффективные. Это, конечно, все равно улучшает позиции сайта, но незначительно.

Повысить результативность и скорость сбора семантического ядра может использование автоматизированных сервисов. С их помощью формирование процесс не займет больше двух минут. Оптимизатору останется лишь убедиться, что все запросы подходят для целей компании.

К таким программам относятся, например, SEMrush и Key Collector. Эти сервисы платные — доступ к ним предоставляется на срок от месяца.

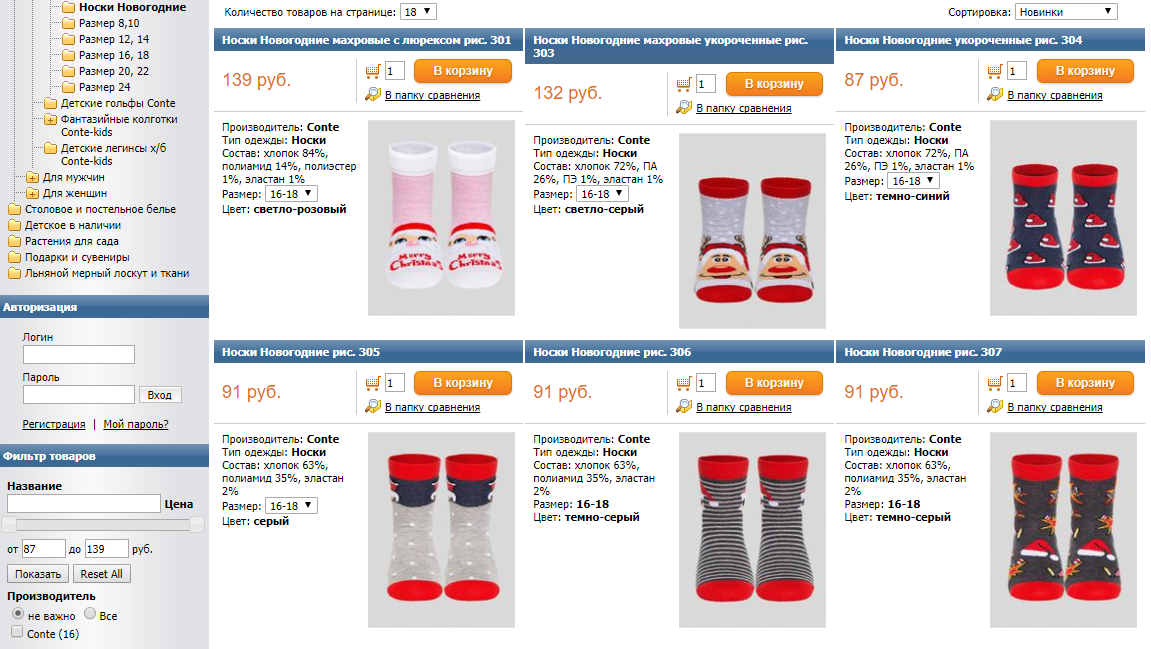

Второй распространенной ошибкой является неудобная для пользователя структура сайта. Например, может быть недостаточное количество фильтров, тегов и подкатегорий. Это сказывается на удобстве использования поиска по товарам. Когда процесс слишком сложный для пользователя, то ваш потенциальный клиент, скорее всего, уйдет на другой сайт.

Так, если в вашем онлайн-магазине выложено двести пар носков, то не стоит все их добавлять в одну категорию “Носки” без возможности отфильтровать. Не надо заставлять пользователей долго прокручивать весь ваш ассортимент. Намного удобнее для них будет наличие отдельной страницы для узкоспециализированных запросов. Например, поисковой фразе “новогодние носки 36 размер” должна соответствовать страница с несколькими подходящими парами.

Многие сайты уже используют этот прием, и пользователи привыкли находить максимально подробный и удобный ответ на свой запрос. Сейчас люди быстро понимают, когда структура сайта плохо продумана.

Выводы

Хотя и кажется, что поисковики, ежедневно изменяя свои алгоритмы, стараются сделать все, чтобы усложнить жизни SEO-специалистов, это не так. Изменения, по большей части, объясняются борьбой со спамом, а значит помогают сайтам, продвигаемым с использованием честных методов. Нововведения также направлены на повышение рейтинга качественных сайтов, что является отличным поводом для вас становиться лучше.

Вне зависимости от изменений в основе алгоритмов всегда лежат одни и те же принципы. Поэтому качественно настроив SEO один раз, можно почти забыть о постоянных нововведениях.

- поисковые алгоритмы

- сео

- поисковая оптимизация

Новые алгоритмы Яндекс YATI и Google Bert: как они влияют на SEO-оптимизацию сайта

В 2019 году был анонсирован новый алгоритм BERT от Google. Главная цель — это улучшение понимания ботами поисковых запросов пользователей. Со слов вице-президента Гугл Панду Найака не совсем было понятно, зачем понадобился новый масштабный апдейт, если у алгоритма будут аналогичные задачи, как и у предшественников. Например, у RankBrain, который был запущен в 2015 году. Материал по теме: SEO-оптимизация: как сделать голосовой поиск на сайтеХотя благодаря «Колибри» больше не нужно разбивать длинную поисковую фразу на отдельные фрагменты, чтобы получить релевантную выдачу, сложности остались. Итак, посмотрим глубже на проблемы, которые способен решать BERT. В первую очередь, у пользователей возникали проблемы с омнонимами. Например, если нужно купить садовую косу, то помимо инвентаря, поисковик выдавал советы, как заплетать волосы. Во-вторых, возникали сложности с интерпретацией длинных запросов с предлогами, если часть речи меняет смысл фразы. BERT же способен понимать языковую речь и выдавать ответы на запросы не только в рамках контекста отдельных слов, а и фразы. Нейросеть может:

-

Правильно интерпретировать длинные предложения с предлогами, которые влияют на конечный смысл.

Предположительно алгоритм работает с запросами с длинным хвостом. То есть, брендовые и короткохвостые фразы BERT не интересуют. Кроме того, алгоритм снизил ценность показателя плотности ключевых фраз. Этот нюанс стоит учитывать при оптимизации контента на сайте.

Влияние BERT на SEO-оптимизацию сайта

- В первую очередь алгоритм влияет на ранжирование контента, адаптированного под голосовой поиск. Если раньше поисковик обрабатывал команды голосовых ассистентов при помощи анализа главных конструкций, то теперь Google ориентируется на смысл фразы.

- В 2021 году BERT используется для формирования расширенных сниппетов на более чем 70 языках.

- Алгоритм оказывает влияние и на построение классических сниппетов. Раньше оптимизаторы при заполнении мета-тегов старались повысить кликабельность и при этом повлиять на ранжирование сайта в SERP. В перспективе нужно будет концентрировать исключительно на улучшение показателя CTR.

- На контент-стратегию. Теперь отпадает необходимость писать переоптимизированные тексты, которые теоретически могли улучшить позиции сайта в поисковой выдаче. При этом лонгриды в 2021 году продолжают быть актуальными, особенно после резкого скачка популярности мобильных ассистентов.

Хотим отметить, что новый алгоритм не слишком повлиял на мир SEO. Некоторые владельцы сайтов в первое время после запуска апдейта отмечали колебания в позициях поисковой выдачи. Но в отличие от Panda, который заставил пересмотреть стратегию оптимизации, BERT не стал «угрозой» для проектов, которые придерживались рекомендаций Google по созданию контента. При этом алгоритм открыл новые возможности для продвижения площадок. Если раньше оптимизаторы сталкивались со сложностями из-за особенностей сегмента рынка, тематики проекта, названий бренда или продукта, то теперь стало проще. Важно соблюдать главное условие — генерировать полезный и информативный контент.

Оптимизация сайта под алгоритм BERT

Google сразу после запуска апдейта дал карт-бланш оптимизаторам: специально ничего делать на сайте не нужно. Алгоритм был запущен, чтобы лучше понимать опубликованный на площадках контент, и сделать выдачу по пользовательским запросам релевантной и точной. Если ресурс просел в позициях по запросы с длинным хвостом, то, скорее всего, страница несправедливо занимала место в ТОП-10 и не соответствовала цели поиска пользователя. То есть, произошло смещение акцентов. Поэтому необходимо пересмотреть весь контент, который есть на сайте на соответствие контексту.

Итак, первая рекомендация, которую дает поисковик — пишите естественно. То есть:

- Не используйте ключи, которые искусственно внедрены в текст статьи.

- Контент должен соответствовать тематике запроса.

- Статьи должны быть информативными.

Важно детализировать контент. Не делайте акцент на один лишь текст. Читателю будет неинтересно изучать «полотно» из букв. Разбавьте статьи видео, инфографикой, изображениями и так далее.

Дэнни Салливан из Google предложил сделать акцент на нетривиальных ответах. Имеется в виду нестандартные формулировки, которые привлекают внимание пользователей. Используйте разговорные фразы, чтобы пользователям было легче воспринимать написанное. Благодаря этому сайт будет лучше ранжироваться по голосовым запросам.

Еще пара нюансов, на которые нужно обратить внимание при оптимизации сайта под BERT:

- Алгоритм разработан для распознавания длинных и, как правило, низкочастотных поисковых запросов. Для таких ключей сложнее подобрать 100% совпадение.

- Алгоритм упрощает поиск по информационным фразам.

Не нужно добавлять такие ключи в текст или в теги в прямом вхождении или разбивать на фрагменты. Можно написать статью, используя синонимы, которые будет соответствовать запросу аудитории.

BERT будет постепенно совершенствоваться. Русскоязычная версия хуже прошла пре-тренинг, чем англоязычная, поэтому разработчики будут продолжать тестировать и апгрейдить алгоритм. Пока оптимизаторам нужно сосредоточиться на созданию естественного и информативного контента, чтобы сохранить позиции в ТОПе выдачи или продвигать новые посадочные страницы.

Яндекс YATI: полная инструкция

1. Принцип работы алгоритма YATI от Яндекса

В 2020 году был запущен новый алгоритм Яндекса YATI или Yet Another Transformer with Improvements, что можно дословно перевести — «еще один трансформер с улучшениями». В последние несколько лет поисковики стремились улучшить качество поисковой выдачи. Особенно это касалось путаницы в SERP, когда пользователь использовал разговорную речь или вводил сложные и длинные запросы. Яндекс, как и Гугл, столкнулся с проблемой невозможности целиком распознать контекст фразы, не разбивая предложение на отдельные слова.

Вначале нейросеть сопоставляет пользовательский запрос и контент, который открывала аудитория по этому ключу. Затем YATI обучается на статьях с разметкой колокеров. И заключительный этап происходит при помощи эталонного контента по запросу, который одобрен асессорами поисковика. То есть, трансформер в будущем может заменить живого эксперта, и на основе полученных в процессе анализа данных, принимать решение о ранжировании страниц. Также алгоритмом будет учитываться информация по кликам в выдаче и анкоры URL, которые ведут на конкретный контент.

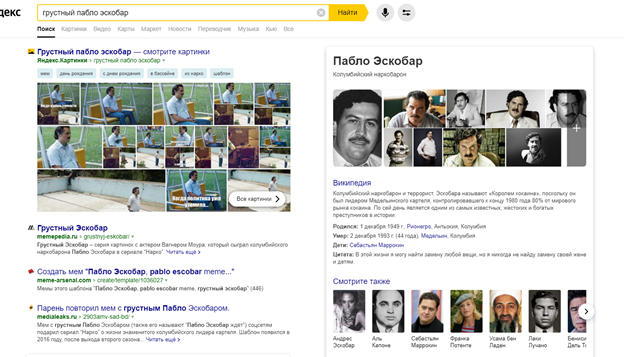

Главная задача алгоритма 2020 Яндекса YATI — повысить точность выдачи. Например, на запрос «грустный Пабло Эскобар» поисковик показывает, как изображения с актером Вагнером Моура, который сыграл наркобарона, так и страницу с Википедии об исторической личности.

И хотя семантическая связь ключа с контентом уже использовалась ранее в Палехе и Королеве, новый алгоритм Яндекса YATI 2020 года эффективней предшественников. Сотрудники поисковика называют апдейт прорывом, который сравнялся по значимости с Матрикснетом.

Если сравнить YATI и BERT, то первый алгоритм выигрывает, хотя оба трансформеры и помогают улучшить релевантность поисковой выдачи. Но Яндекс добавил помимо распознавания контекста еще и анализ вероятного количества кликов по линку.

2. Влияние YATI на SEO-оптимизацию сайта

Новый алгоритм повлиял на стратегию оптимизации сайтов. В первую очередь, чтобы не потерять позиции в поисковой выдаче или, наоборот, улучшить их, нужно:

- Повысить качество контента. Из ТОПа постепенно будут исчезать малоинформативные или нерелевантные страницы. Кроме того, введение жестких санкций Яндекса против накрутки поведенческих факторов в 2020 году, сократило количество ресурсов в SERP.

- Дать информативный ответ на пользовательский запрос. Контент в первую очередь должен закрывать проблему аудитории. Задача материала — удержать пользователя на странице, чтобы человек опять не вернулся в SERP в поиске другого сайта.

- Добавить в семантическое ядро низко- и микрочастотные поисковые запросы. В тексте также должны присутствовать синонимы, тематические фразы, другие формулировки ключевых предложений, чтобы увеличить вероятность выдачи страницы в ответ на вопрос пользователя.

- Публиковать лонгриды. Контент длиной 2-3 тысячи слов стал лучше ранжироваться — это факт. Если раньше поисковик анализировал только заголовки и подзаголовки, а также отдельные вхождения высокочастотных ключей, то в 2021 году боты могут выделять релевантные запросу фрагменты по тексту. Кроме того, чем длиннее статья, тем на большее количество вопросов можно дать ответ. Объём зависит от темы. Не нужно пытаться «высосать из пальца», чтобы искусственно добавить количество предложений. Такую статью вряд ли захотят читать.

3. SEO-оптимизация страниц под YATI

Важно сосредоточиться на сборе полной семантики, которая будет включать запросы с длинным хвостом и разговорную речь. За счет того, что аудитория стала чаще использовать голосовой поиск, приоритет таких ключей возрастает с каждым годом. Сосредоточьтесь на синонимах, чтобы расширить семантическое ядро. При кластеризации рекомендуем учитывать потребительские интеты. Чтобы облегчить задачу можно использовать дополнительные инструменты, например, PromoPult.

Не нужно создавать сотни однотипных посадочных страниц под ключи с длинным хвостом. Лучше сосредоточиться на создании контента, который сразу закроет пару-тройку вопросов аудитории. Можно сделать перелинковку на другие страницы, релевантные теме, чтобы улучшить поведенческие факторы. Такая тактика используется для блогов.

Не забывайте про структуру контента. Помимо списков и заголовков можно встраивать цитаты, скриншоты. Для интернет-магазинов — отзывы клиентов. Чтобы улучшить информативность содержимого страницы для поисковых краулеров, используйте микроразметки Schema.org или Open Graph.

Как видите, начиная с 2019 года, поисковики требуют, чтобы оптимизаторы генерировали информативный и естественный контент. Положительный пользовательский опыт на сайте играет главную роль. Те ресурсы, которые не будут давать полные ответы на вопросы аудитории, постепенно скатятся вниз в рейтинге поисковой выдачи.

Предлагаем вам ознакомиться с нашей услугой «SEO-продвижение» или оставить комментарий внизу.

Автор: Exiterra Digital Agency

Источник https://habr.com/ru/articles/351930/

Источник https://exiterra.ru/blog/prodvizhenie-sajta/novye-algoritmy-yandeks-yati-i-google-bert-kak-oni-vliyayut-na-seo-optimizatsiyu-sayta/