SEO Аудит сайта в 2023 — каким должен быть?

SEO-аудит сайта — это проверка вашего сайта на соответствие требованиям Google и других поисковых систем, подготовка рекомендаций для устранения проблем, мешающих продвижению.

Обычно SEO-аудитом ошибочно называют именно технический аудит сайта. Поэтому, как его результат, привыкли получать файл с малопонятными техническими требованиями. Например, добавьте «это» в robots.txt, закройте «те» ссылки в nofollow. Однако поисковые системы активно развиваются, а значит и требования к сайту меняются.

Почему SEO-аудит должен быть комплексным?

Продвижение сайта всегда делается из чисто практических целей. Часто такая цель — получение заявок или увеличение прибыли. То есть конечной целью является не получение позиций или трафика, а монетизация результата этих работ.

Поможет ли получение поискового трафика конечной цели, если форма заявки не отправляется? Или если сайт не вызывает доверия? Или если у конкурентов давно уже намного выгоднее условия или шире ассортимент?

Скорее всего посетитель так и не станет покупателем и пойдет искать дальше, что в свою очередь может привести к снижению позиций вследствие поведенческих факторов.

Каким должен быть результат аудита сайта?

Конечным результатом не должен быть просто список ошибок на вашем сайте. Нередко исправление ошибок может привести к созданию новых, более критичных. Поэтому результатом всегда должен быть файл с четкими требованиями и рекомендациями.

После ознакомления с поисковым аудитом клиент должен сразу увидеть ответы на 2 вопроса:

- Что именно нужно исправить?

- Каким должен быть конечный результат исправления?

Поэтому если вам прислали только часть «это сделано неправильно», требуйте и доработать часть «как именно это исправить».

Что даст проведение SEO-аудита?

Да, сам по себе аудит ничего не изменит, потому что для получения результата недостаточно знать пути исправления проблем. Их нужно исправлять. Поэтому будьте готовы к дополнительным затратам на внедрение изменений.

Аудит нужен, чтобы получить план действий, распределить ответственность и работы. В результате комплексного аудита может быть создан план на 3-10 месяцев, который должен включать работу разработчиков, маркетологов, копирайтеров и многих других специалистов.

Из чего состоит комплексный SEO-аудит веб-сайта?

В аудит должно входить довольно много различных проверок: от технических проблем до удобства использования. Однако для разных сайтов набор может быть разным. К примеру, сайту СМИ с высоким поисковым трафиком более важен поиск точек роста, чем технический аудит. Можно предположить, что сайт не имеет критических технических проблем, если он уже получает большой трафик и отсутствует отрицательная динамика. Тогда как молодой сайт с растущим трафиком наоборот может не раскрывать свой полный потенциал из-за технических проблем.

Общий аудит сайта в 2023 году состоит из 12 частей.

1. Внутренний или технический аудит

Это неизменная основа основ. Невозможно продвигать сайт, который не индексируется поисковыми системами.

В рамках этого аудита проверяются:

- настройка сканирования и индексации сайта;

- доступность всех важных страниц для краулера (поискового робота) Google;

- наличие битых ссылок или ненужных переадресаций страниц;

- корректность формирования URL дружественных к SEO;

- микроразметка;

- уязвимость к дублированию или проблемам с rel=»canonical»;

- формирование нужных карт сайта;

- валидность или наличие корректных HTTP заголовков и тому подобное.

Результат: малопонятный неспециалисту файл с техническими рекомендациями.

2. Аудит быстродействия сайта (Website Performance Audit)

С мая 2020 года Google заявил, что включает метрики скорости загрузки сайта в факторы ранжирования. Насколько сильно это влияет на ранжирование до сих пор обсуждается специалистами, однако неоспоримым фактом является то, что пользователи лучше относятся к сайтам, которые загружаются быстрее, следовательно, и поведенческие факторы у таких сайтов будут конкурентные.

В рамках этого аудита проверяются все метрики загрузки сайта, но особое внимание уделяется так называемым Core факторам:

- LCP (Largest Contentful Paint) — скорость загрузки основного контента страницы;

- FID (First Input Delay) — время ожидания взаимодействия;

- CLS (Cumulative Layout Shift) — совокупное смещение макета;

- INP (Interaction to Next Paint) — задержка при взаимодействии (в ближайшем будущем заменит FID в Core Web Vitals).

Результат: рекомендации действий для улучшения важных метрик загрузки страницы.

3. Аудит контента

Content is king — говорят маркетологи, и они правы. Вы не добьетесь успеха в поисковом продвижении, если страницы вашего сайта не оптимизированы или не содержат контента, удовлетворяющего intent (намерение) пользователя.

В рамках аудита содержимого сайта проверяется:

- наличие и оптимизация метатегов страниц;

- структура и форматирование текстов;

- наличие ответов на вопросы пользователя;

- анализ типов страниц и их наполнение;

- актуальность страниц с наибольшим процентом посещений;

- соответствие контента бизнес целям и тому подобное.

Результат: рекомендации — как оптимизировать имеющийся контент, что и как писать в будущем.

4. Аудит внешних ссылок

Если контент король, то ссылки — рыцари. Именно ссылки придают силы контенту. Без сильных ссылок не будет высоких позиций, и наоборот, плохие ссылки могут блокировать выход сайта в топ выдачи.

В рамках этой проверки нужно провести:

- сбор из разных источников списка внешних ссылок;

- проверку на спамность или низкое качество;

- анализ анкорных текстов;

- проверку утерянных ссылок (на удаленные страницы или сломанную переадресацию).

Результат: дашборд с вашими ссылками и рекомендации, от каких ссылок стоит отказаться, какие страницы стоит вернуть или переадресовать.

5. On-page аудит

Пользователи обычно приходят не на сайт в целом, а на одну из его страниц. Поэтому стоит проверять, все ли сделано правильно в рамках посадочной страницы.

On-page аудит включает в себя:

- проверку структуры заголовков;

- наличие технических заголовков;

- проверку кода страницы;

- оптимизация изображений на странице;

- наличие ненужных элементов и тому подобное.

Результат: рекомендации по доработке важных посадочных страниц.

6. Аудит основных конкурентов

Этот аудит включает 2 проверки: контента и ссылок. В рамках аудита контента конкурентов проверяются:

- тексты;

- ассортимент;

- межстраничные ссылки;

- SEO-структура и тому подобное.

Аудит ссылок включает в себя:

- сбор данных о ссылках конкурентов;

- анализ динамики;

- анализ страниц, на которые ссылаются;

- анализ анкорного текста;

- создание сравнительной таблицы.

Результат: сравнительная таблица, где четко видно разницу (или ее отсутствие) в ссылках, и план действий по наращиванию ссылочной массы вашего сайта.

7. Аудит онлайн репутации (SERM аудит)

Ваши продажи напрямую зависят от доверия покупателей. Поэтому важно мониторить, что о вас пишут, и какие сайты занимают топ выдачи по вашим брендовым запросам.

В рамках Search Engine Reputation Management аудита требуется:

- выделить важные брендовые запросы;

- проанализировать тональность отзывов;

- настроить мониторинг отзывов о вашем бизнесе.

Результат: рекомендации по работе с отзывами, улучшению выдачи и план действий для уменьшения негатива в топе выдачи.

8. Юзабилити аудит

Аудит удобства сайта ставит целью выявление проблем, которые мешают пользователям совершать целевые действия: транзакции, отправка заявок или поиск контента.

- визуализацию пути пользователя по сайту;

- анализ поведения пользователей в сервисах типа Clarity, Hotjar;

- анализ тепловых карт и карт скролла (прокрутки);

- QA проверку основных действий пользователей и тому подобное.

Результат: список проблем с возможными вариантами исправления и гипотезы для A/B тестирования.

9. Аудит аналитики

Вебаналитика — это именно то, чем большинство руководствуется при принятии тех или иных решений в digital-маркетинге. Однако часто эти решения принимают на неполных или неправильных данных. Именно «чистоту» данных и должен проверять этот аудит.

Аудит аналитики включает в себя:

- проверку правильности подключения сервисов;

- наличие всех страниц в аналитике;

- отсутствие дублирования данных;

- наличие всех важных событий, конверсий и тому подобное.

Результат: рекомендации для исправления ошибок и measurement план по дополнению важных данных в аналитике.

10. Анализ имеющихся данных

Google Search Console и другие инструменты аналитики содержат много инсайтов о вашем сайте. Именно получение таких инсайтов и ставит целью эта проверка.

Аудит данных аналитики может включать:

- поиск типов контента, которые лучше всего приводят или конвертируют трафик;

- анализ страниц, потерявших трафик;

- анализ упущенной семантики и тому подобное.

Результат: рекомендации по дополнению, обновлению или созданию нового контента.

11. Аудит E-E-A-T и коммерческих факторов

Google создает все больше требований не только к контенту, но и к авторам и их экспертизе. Именно об этом и говорит принцип E-E-A-T — Experience, Expertise, Authoritativeness, and Trustworthiness (опыт, экспертиза, авторитетность и надежность).

В рамках этого аудита проверяется:

- необходимая микроразметка;

- подтверждение экспертизы и персоны автора;

- наличие важных коммерческих страниц;

- дополнительные факторы доверия к сайту или контенту.

Результат: рекомендации по созданию или дополнению важных страниц.

12. Поиск точек роста

Одна из основных задач аудита — найти дополнительные методы роста. К сожалению, этот анализ невозможно сделать без предыдущих пунктов, именно поэтому он проводится последним.

Анализ возможных точек роста включает:

- поиск пропущенных типов контента;

- анализ эффективности конкурентов;

- анализ внутреннего потенциала сайта;

- анализ потенциала фраз и тому подобное.

Результат: прогноз трафика и предложения по созданию новых типов контента (или оптимизации существующих).

Нужен ли вам комплексный SEO-аудит?

Если вам нужна золотая пилюля или кнопка «сделать хорошо», тогда нет. Аудит вряд ли даст желаемое.

Если вы хотите увеличивать органический трафик, масштабироваться и готовы вкладывать энергию в улучшение сайта и бизнеса, тогда однозначно да. Но впереди будет очень много работы.

Запомнить

- SEO-аудит сайта — это проверка сайта на соответствие требованиям поисковых систем и подготовка рекомендаций для устранения проблем, мешающих продвижению.

- Результатом аудита должен быть файл с четкими требованиями и рекомендациями по улучшению сайта.

- SEO-аудит охватывает следующие этапы:

- технический аудит;

- аудит быстродействия сайта;

- аудит контента;

- аудит внешних ссылок;

- on-page аудит;

- аудит основных конкурентов;

- аудит онлайн-репутации;

- аудит юзабилити;

- проверка аналитики;

- аудит имеющихся данных;

- аудит Е-Е-А-Т;

- изучение коммерческих факторов;

- также поиск точек роста.

- Сам по себе аудит ничего не изменит, но даст план работ на 3-10 месяцев, результатом которых станет улучшение ранжирования сайта и увеличение заявок с него.

В интернет-маркетинге с 2011 года. В SEO прошел путь от региональных сайтов до крупных порталов.

Сейчас SEO-специалист в Netpeak Agency.

Узнайте больше

10

Как проверить сайт на SEO-ошибки и найти точки роста трафика проекта: пошаговый мануал

Некомплексный подход к аудиту сайта — одна из распространённых ошибок агентств и фрилансеров. Тратя время и деньги на исправление одной ошибки на странице, вы можете не увидеть более серьёзные проблемы на всём сайте, которые тормозят продвижение.

Другими словами, без понимания картины происходящего есть большие риски неправильно приоритизировать задачи. Это повлечёт за собой не только слабую динамику результатов, но и большие затраты на их достижение.

В посте я расскажу, как избежать этих проблем с помощью инструмента, в котором можно регулярно агрегировать данные, быстро их анализировать, а также проводить анализ сайта на SEO-ошибки. Он поможет вам грамотно расставлять приоритеты, находить точки роста и эффективнее продвигать сайт.

- 1. Главные преимущества подхода

- 2. Основные этапы сбора данных для полноценного SEO-аудита

- 3. Что получаем в итоге

- 4. Как это применить

- 5. Нюансы, которые важно учитывать

- Подводим итоги

1. Главные преимущества подхода

Решение проблемы я нахожу в использовании онлайн-приложения Google Таблицы. Оно позволяет агрегировать данные, а также имеет ряд преимуществ, среди которых:

- Комплексность. Данные из разных источников находятся в одном месте.

- Скорость. Анализ данных, поиск инсайтов и точек роста происходит за минимальное количество времени.

- Доступность и простота. Google Таблицы — бесплатный и универсальный инструмент для агрегации данных.

- Кастомизируемость. Возможность менять, удалять, добавлять данные в любой момент времени.

2. Основные этапы сбора данных для полноценного SEO-аудита

Я буду описывать подход на примере интернет-магазина, но методика работает и с другими типами сайтов.

Этап первый. Сканирование сайта

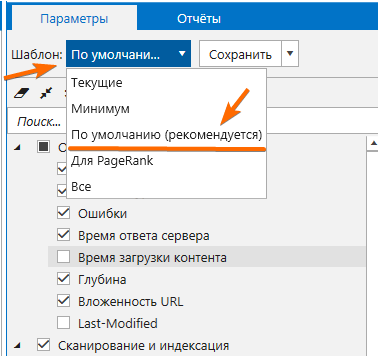

Сканирование я провожу в краулере Netpeak Spider. Чтобы получить нужные данные, в программе задаю такие настройки:

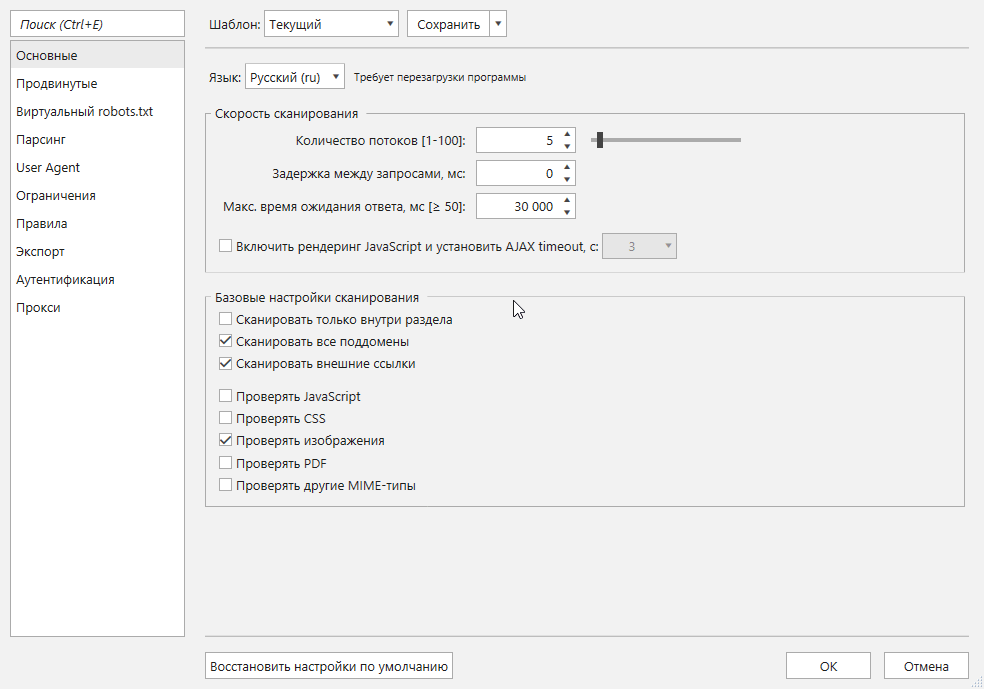

- На вкладке «Настройки» → «Основные» выставляю количество потоков (в моём случае — 5). И отмечаю все пункты базовых настроек, кроме сканирования внутри раздела.

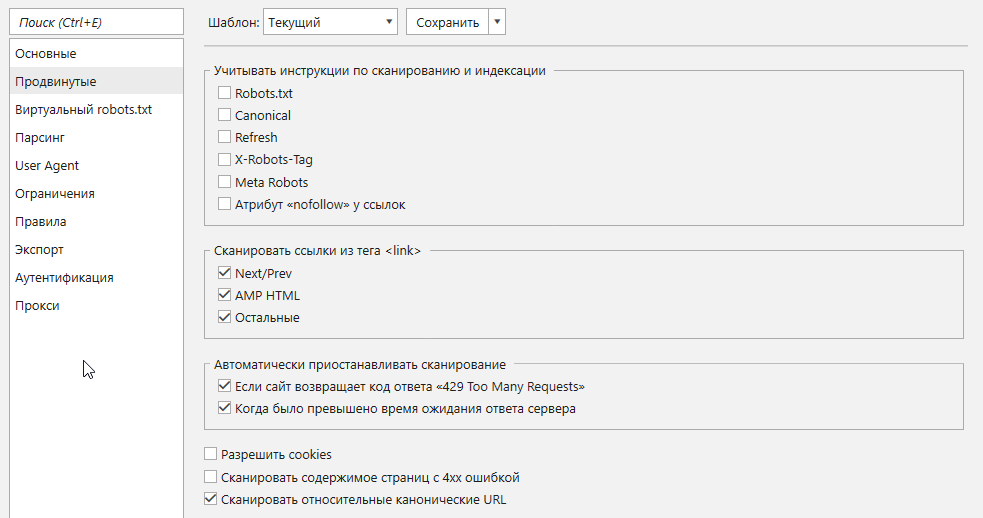

- На вкладке «Продвинутые» оставляю пустым чекбокс «Учитывать инструкции по сканированию и индексации». Это позволит найти большее количество страниц и проверить правильность настройки инструкций.

- На вкладке «Google Analytics и Search Console» добавляю аккаунт и на боковой панели программы отмечаю параметры, которые нужны для дальнейшей работы:

- сеансы (за последние полгода или меньше);

- показатель отказов;

- достижения нужных целей.

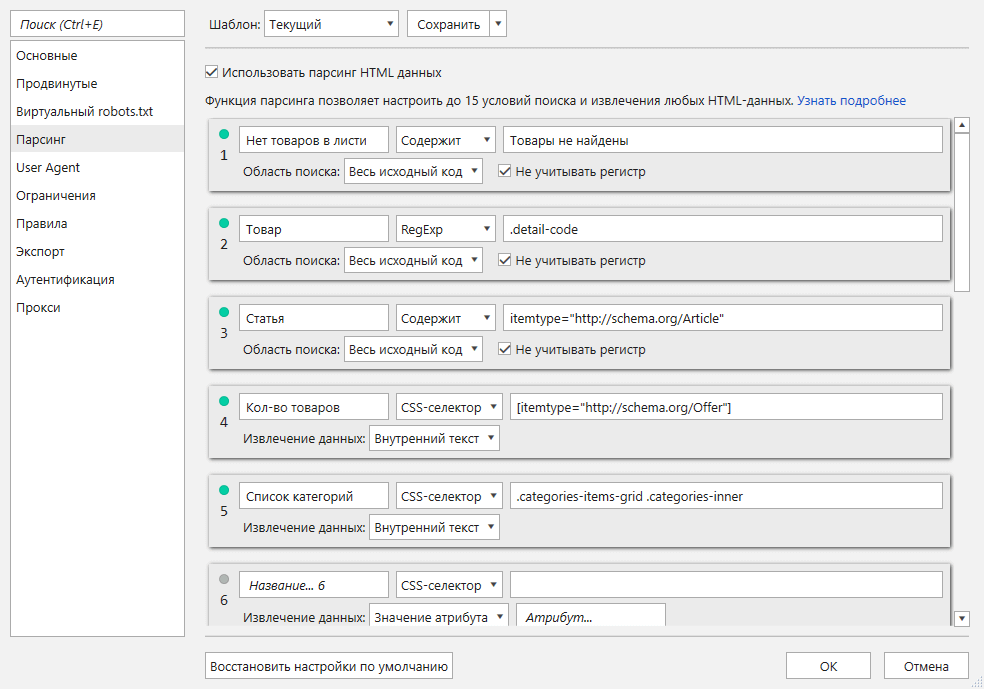

- На вкладке «Парсинг» я заношу регулярные выражения и уникальные коды, чтобы точно определить типы страниц, количество товаров на листингах, список категорий и т. д. Большинство данных я извлекаю из микроразметки. Для рассматриваемого сайта это выглядит следующим образом:

Читайте также: «Как парсить различные данные с помощью Netpeak Spider».

Пока сайт сканируется, я перехожу к следующему этапу.

Чтобы начать пользоваться Netpeak Spider, просто зарегистрируйтесь, скачайте и установите программу — и вперёд! 😉

P.S. Сразу после регистрации у вас также будет возможность потестировать весь платный функционал, а затем сравнить все наши тарифы и выбрать для себя подходящий.

Этап второй. Проверка индексации

Для проверки наличия страниц в индексе вы можете воспользоваться Netpeak Checker, Rush Analytics, Overlead.me и другими инструментами.

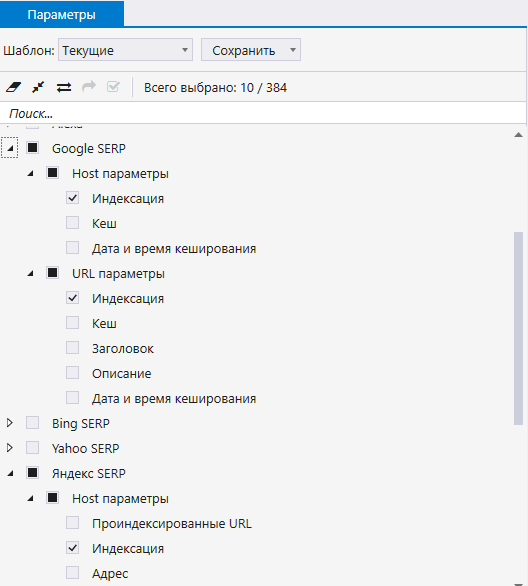

В Netpeak Checker это делается следующим образом:

- Вставьте список страниц сайта, который вы получите с помощью Netpeak Spider.

- На боковой панели отметьте пункты «Google SERP» или «Яндекс SERP», после чего запустите сканирование.

Вы можете сэкономить на проверке индексации и считать сразу проиндексированными страницы, которые получали показы и трафик за последнюю неделю или две (по данным из Google Analytics и Google Search Console.).

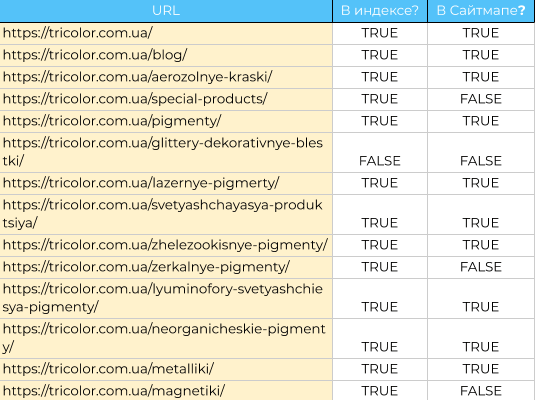

Также нужно узнать, есть ли неиндексируемые страницы в XML-карте сайта. Для этого выгрузите URL из файла Sitemap и просканируйте их. Если вы нашли ошибки на этих страницах, их нужно либо исправить, либо заменить на индексируемые страницы, которых в карте ещё не было.

Этап третий. Определение категорий для сегментации по важным параметрам

На этом этапе я добавляю в таблицу следующие On-Page данные страниц:

- скорость ответа сервера;

- глубина страницы от главной;

- количество слов на странице;

- инструкции по индексации и сканированию;

- title и description;

- заголовки.

Советую использовать категоризацию для параметров с численным показателем (например, количество слов на странице можно разбить на категории: от 100 до 500, от 501 до 1000, от 1001 до 2000), чтобы потом легко сегментировать данные при построении диаграмм.

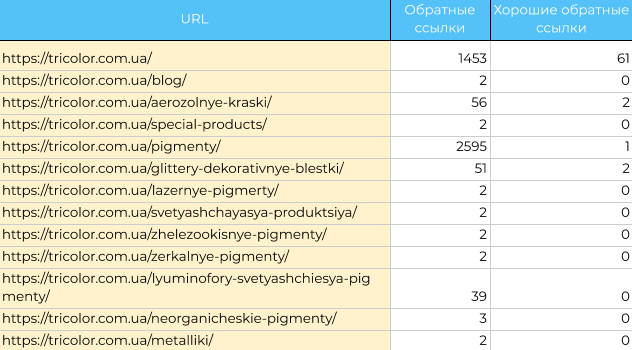

Этап четвёртый. Экспорт и определение качества обратных ссылок

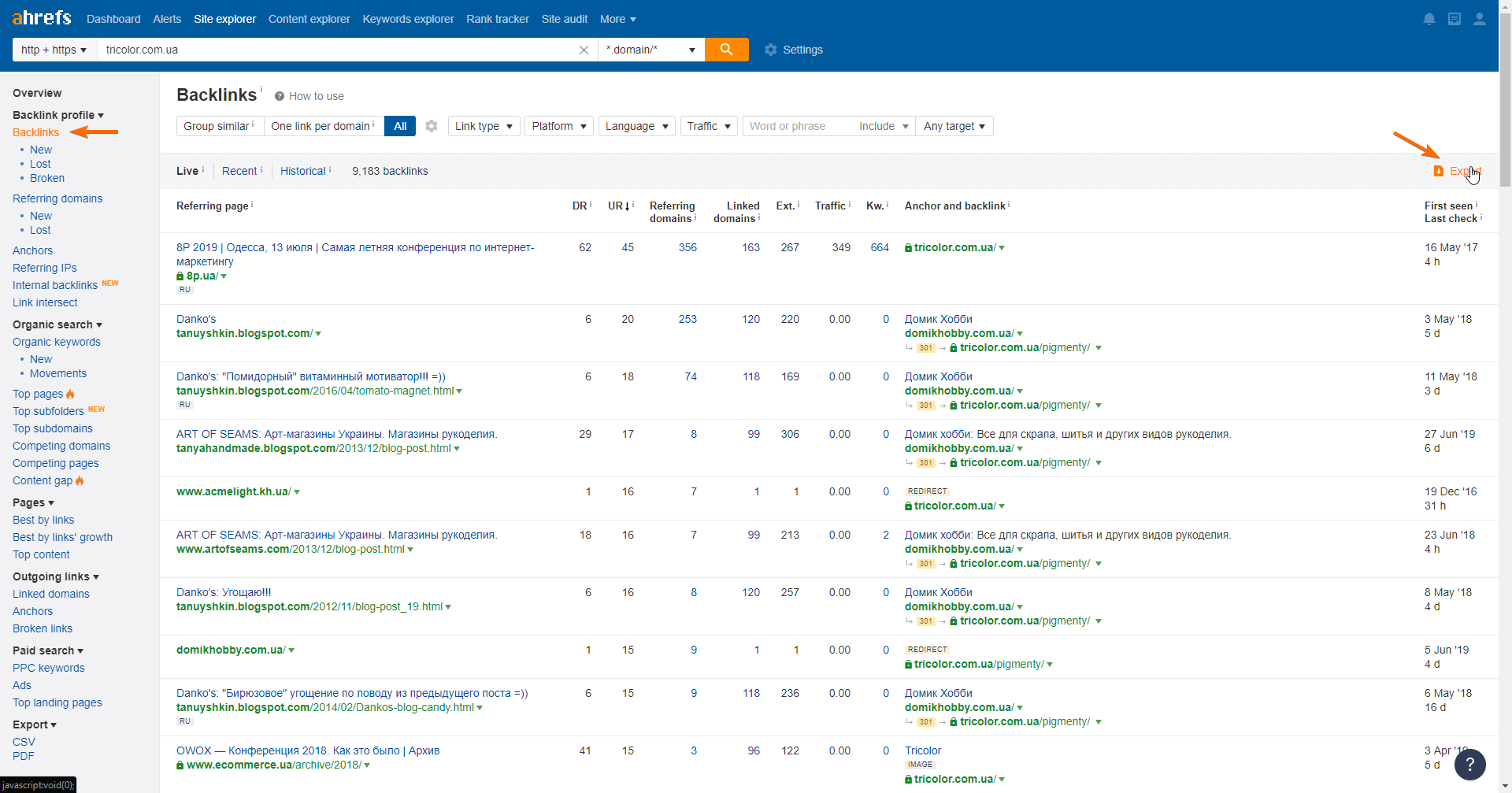

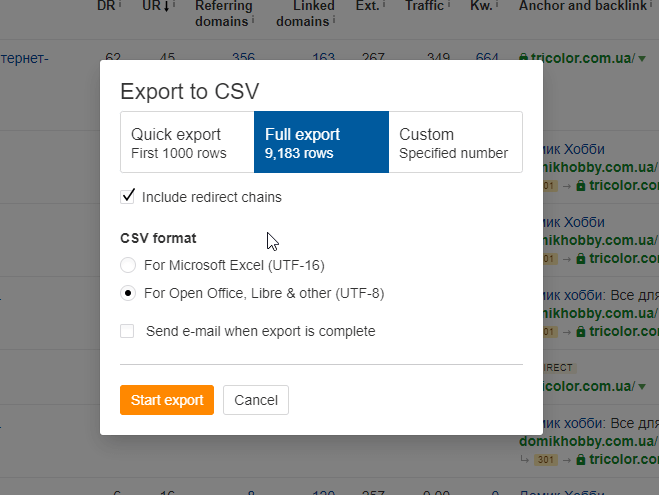

Чтобы собрать все ссылки на сайт, рекомендую использовать несколько сервисов анализа ссылок, а также добавлять вручную ссылки, полученные после кампаний по линкбилдингу (потому что они могут не отобразиться в сервисах).

Как собирать и выгружать обратные ссылки с помощью Ahrefs:

Импортируйте данные из Ahrefs или того сервиса, в котором вы собираете бэклинки, в Google Таблицы и отсортируйте их в таком порядке:

- Referring Page URL;

- Link URL;

- Domain Rating;

- URL Rating (desc);

- Redirect chain (from);

- Redirect chain (to);

- Redirect type;

- Type.

Удалите сквозные ссылки, nofollow ссылки и отделите качественные от некачественных.

Чтобы определить, какие ссылки плохие, а какие хорошие, я опираюсь на два показателя — Domain Rating и URL Rating по Ahrefs. Если первый ниже 15, а второй ниже пяти, то ссылку считаю некачественной.

Хочу заметить, что эти пороговые значения не являются эталонными для всех проектов. Конкретно в этом случае они были выбраны на основании медианной величины DR и UR всех ссылок на этот ресурс.

Таким образом вы увидете, какие из страниц заспамлены, и какие ссылки в будущем вам нужно будет отклонить в Google Disavow Links Tool.

Этап пятый. Оценка видимости для приоритезации продвижения страниц

Если у вас есть собранная семантика, по которой вы собираете данные по позициям и частотности, добавьте её в докс, чтобы смотреть видимость каждой страницы. Если её нет, то данные можно собрать из сервисов Serpstat, Spywords, Keys.so, Google Search Console или Яндекс.Вебмастер.

Соберите общую частотность страницы и количество показов именно по небрендовым ключам. Для чего это нужно:

- Чтобы приоритезировать работу со страницами и понимать за что в первую очередь браться.

- Чтобы увидеть, сколько ключей у страницы находится в топе и видеть потенциал роста.

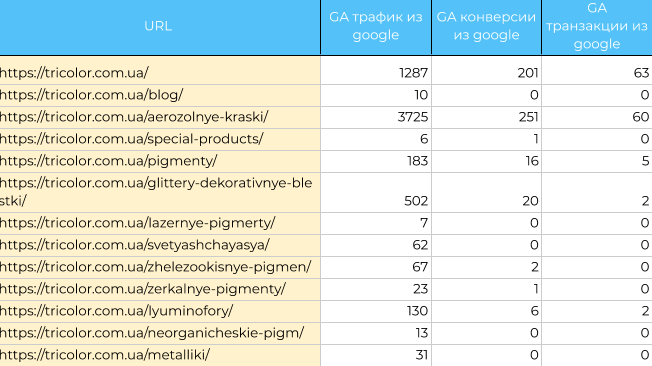

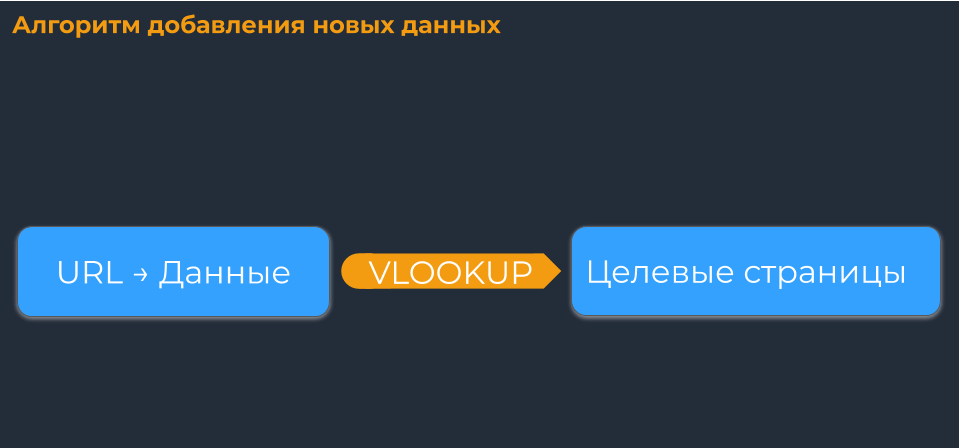

Этап шестой. Сбор данных по трафику и конверсиям

Так как перед сканированием в Netpeak Spider мы использовали интеграцию с Google Analytics и Search Console, то собирать их отдельно не нужно.

Если же вы не собирали эти параметры в Netpeak Spider, то данные можно получить с помощью расширений для Google Таблиц: Google Analytics и Search Analytics for Sheets. Консолидируйте их со страницами, используя функцию VLOOKUP (вертикальный поиск результата). Смотрите не только трафик, но и конверсионность.

Детальный и пошаговый мануал по сбору данных для аудита сайта изложен в этом SOP.

3. Что получаем в итоге

Выполнив все этапы, мы получили данные для комплексного анализа страниц в одном месте. Это позволяет в любой момент времени сделать нужную выборку и ничего не упустить.

Для лучшей приоритезации в таблицу можно добавить:

- данные по посещению страниц роботами из логов;

- данные из CRM (иногда данные по транзакциям, заполнению форм в CRM более точные, чем в аналитике, потому что adblocker может их блокировать);

- данные из систем call-tracking;

- исторические данные по анализируемым параметрам;

- или данные по разным каналам трафика.

Для наглядности посмотрите таблицу с примером SEO-аудита. Вы можете вставлять данные в шаблон, а он автоматически будет определять ошибки с помощью формул Google Таблиц.

Данные из разных сервисов в таблицу вы можете выгружать вручную, но иногда для более быстрого сбора лучше использовать API. Таким образом вы будете собирать их на новые листы, применять функцию VLOOKUP и подтягивать в основную таблицу по каждому URL.

Лайфхак: Если в сервисе нет нужного отчёта, но есть API, воспользуйтесь скриптом IMPORTJSON, который поможет спарсить ответ API прямо в Google Таблицы.

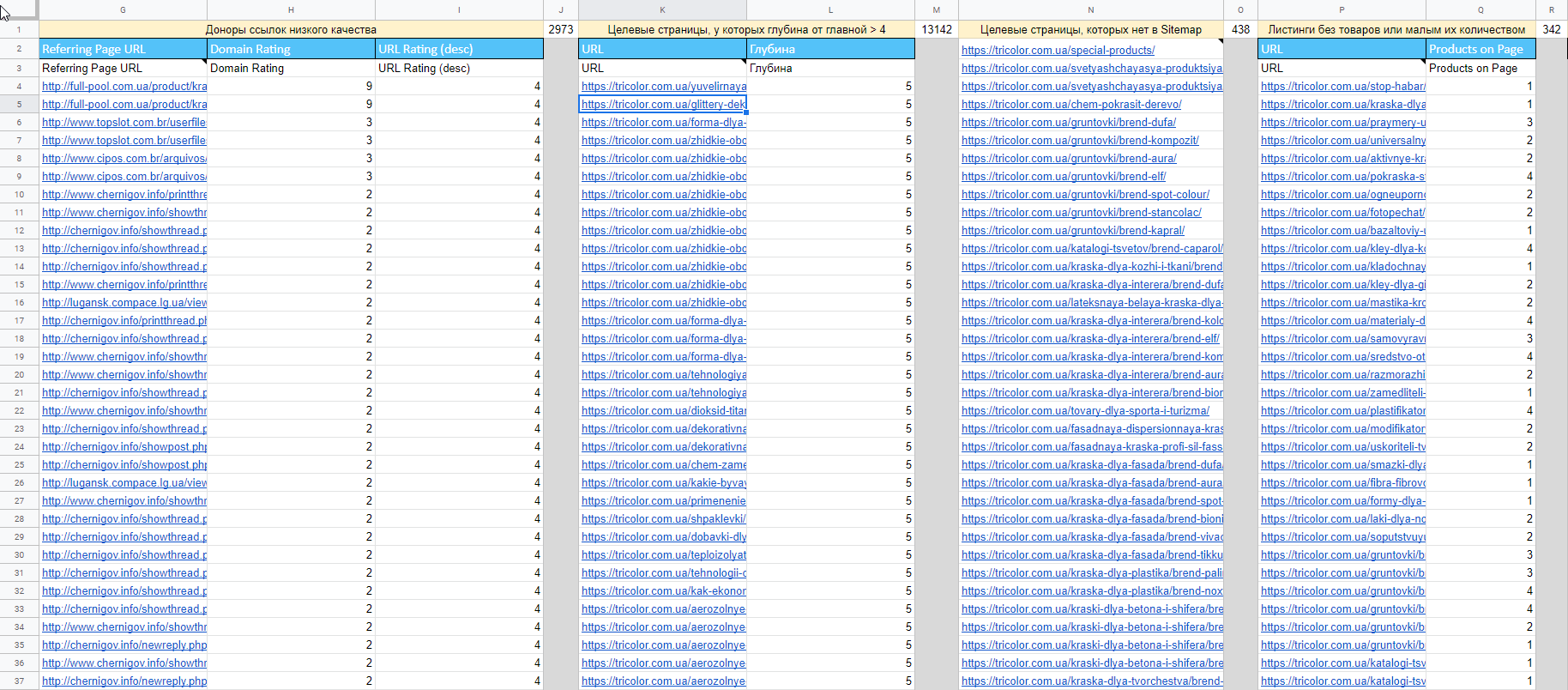

4. Как это применить

Благодаря агрегированным данным вы сможете:

- Определить, какие страницы не попали в индекс.

- Найти доноров ссылок низкого качества.

- Узнать причины неиндексируемости страниц и найти страницы с ошибками в Sitemap.

- Найти нецелевые страницы с трафиком.

- Проанализировать ассортимент сайта и получить листинг товаров, содержащих низкое количество товаров.

- Узнать, какие целевые страницы не добавлены в карту сайта

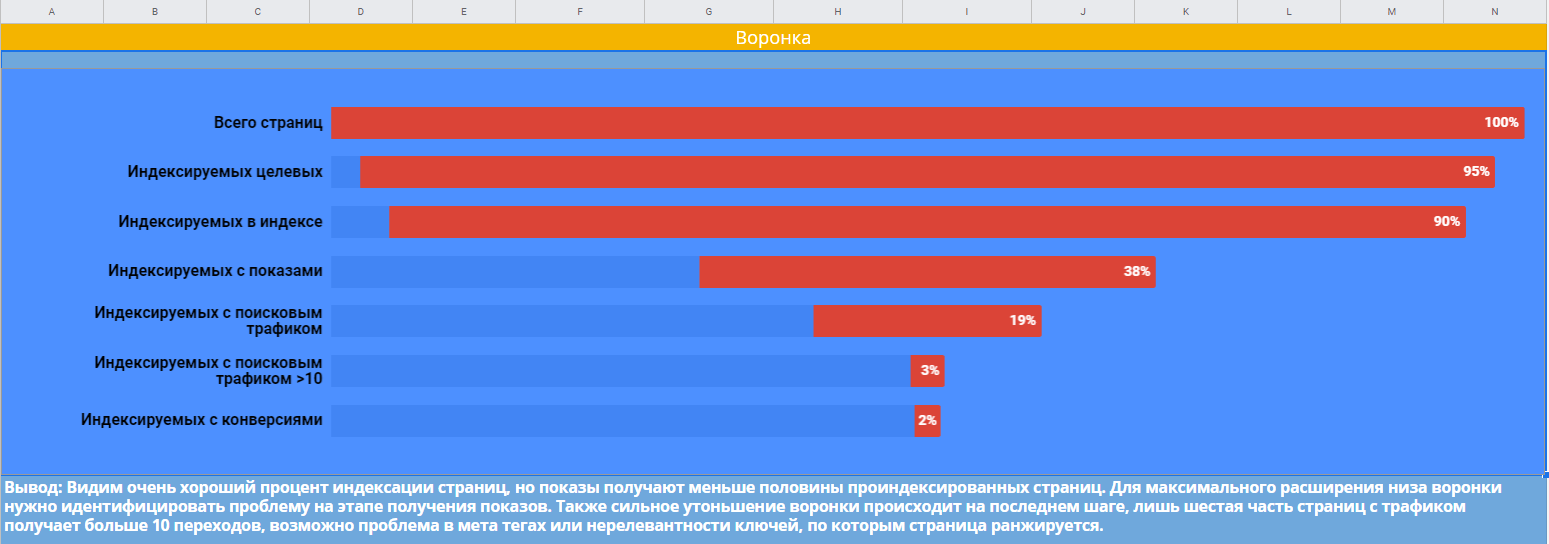

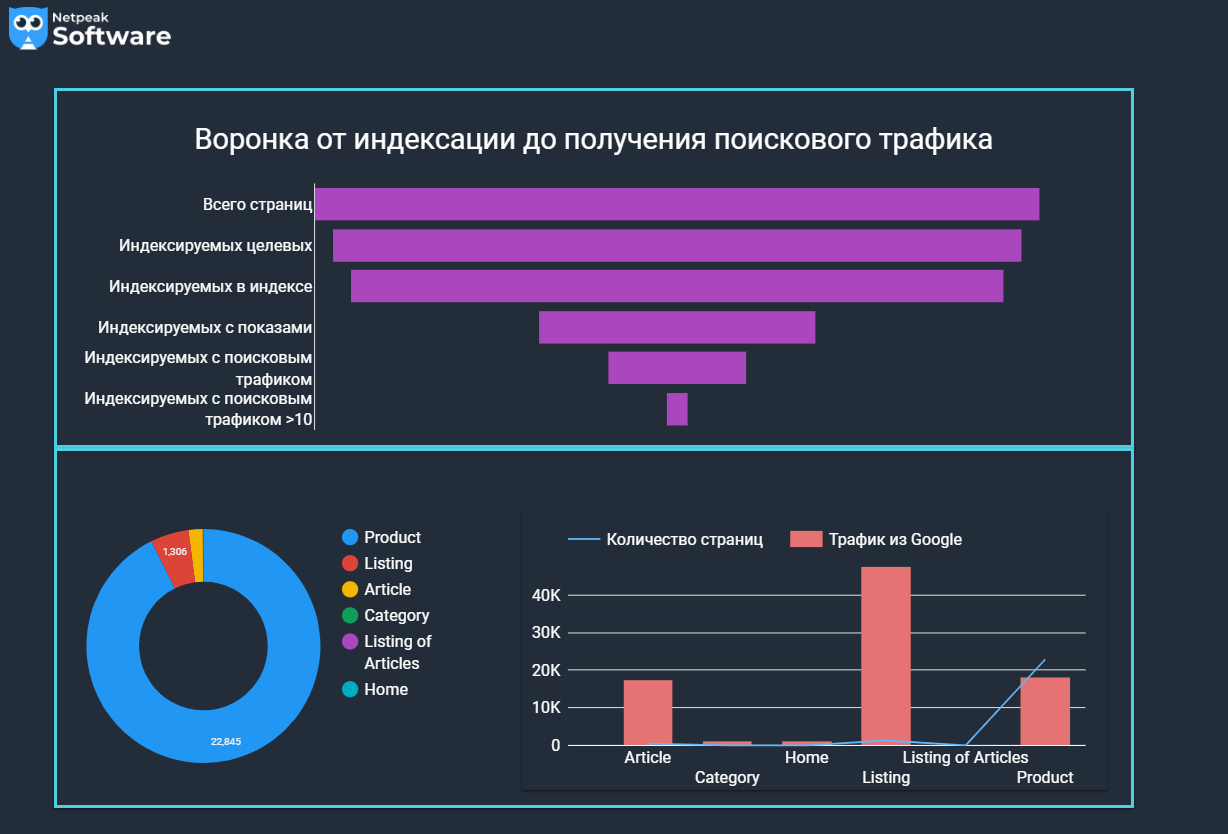

Все эти данные можно визуализировать в Google Таблицах для анализа. Например, диаграмма ниже показывает воронку распределения страниц на этапах от индексации до получения конверсий. Здесь наблюдается значительное сужение воронки на этапе получения показов, и с этим нужно бороться в первую очередь.

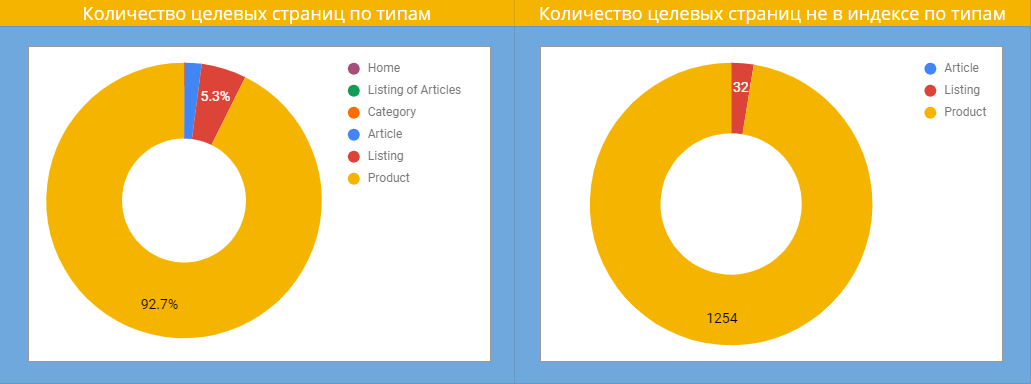

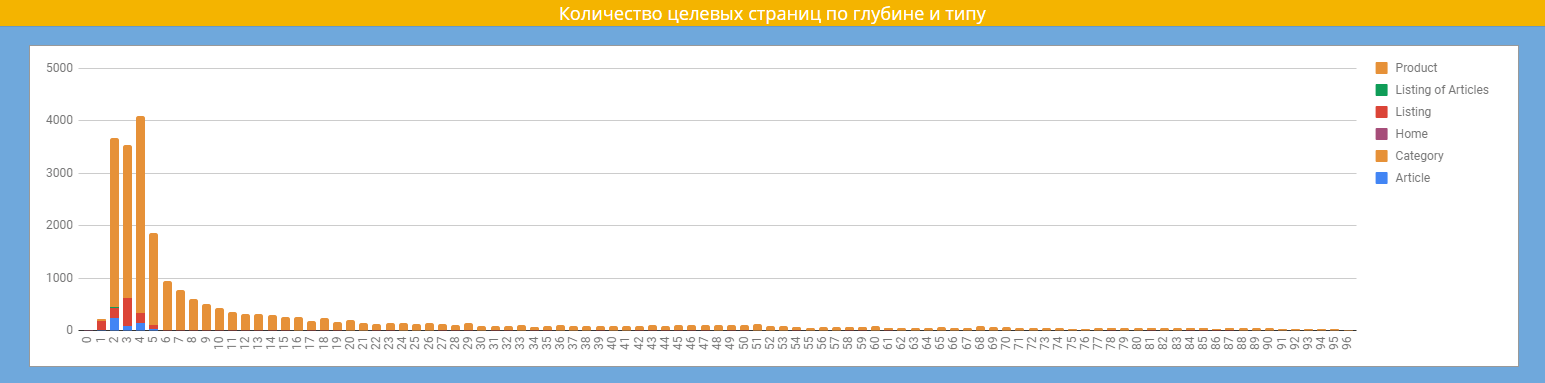

Следующая диаграмма показывает количество страниц каждого типа, и какие из них не индексируются. Можно заметить, что большинство страниц, которые не попали в индекс, — это карточки товаров.

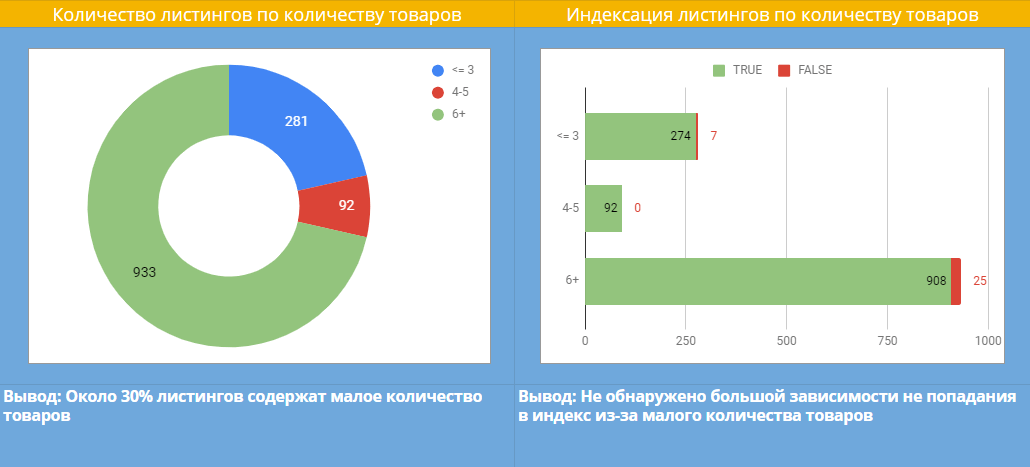

Нам нужно понять, почему так происходит. Для этого анализируем количество товаров на листингах и видим, что 30% листингов содержат небольшое количество товаров. Именно это влияет на индексацию? Нет, так как на диаграмме ниже видно, что прямая корреляция между показателями отсутствует.

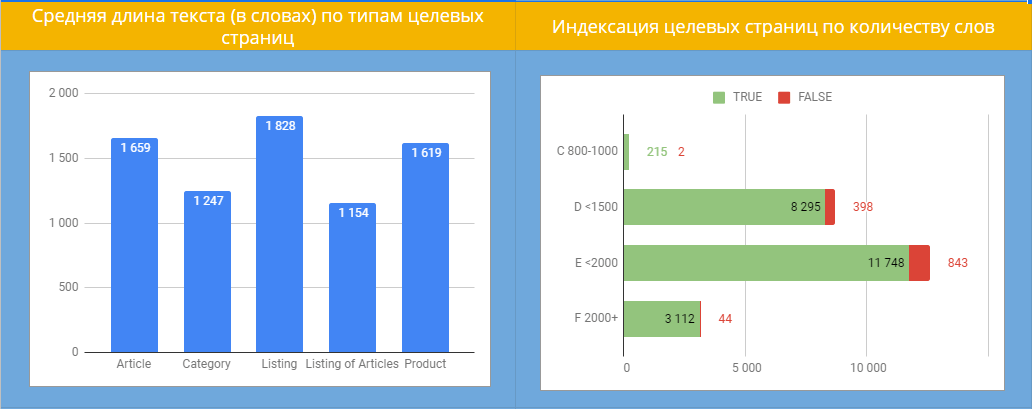

Возможно, причина в контенте. Собираем среднее количество слов на каждом типе страниц и анализируем. Видим, что страницы с малым количеством текста так же хорошо индексируются, как и с большим, поэтому причина не в контенте.

Изучаем глубину страниц сайта и наконец видим, что именно она является причиной плохой индексации. Ищем проблему в алгоритме внутренней перелинковки и добавляем больше фильтров и тегов для лучшего охвата семантики и снижения количества кликов до таких страниц.

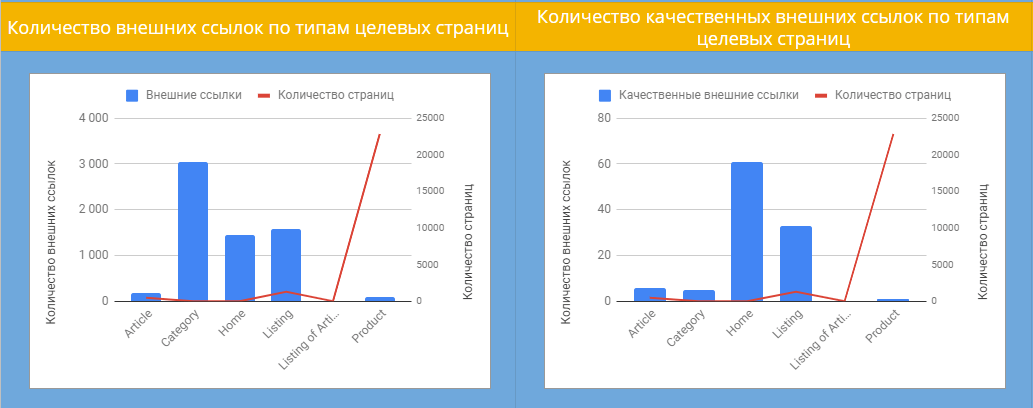

Далее разбираемся, на какие типы страниц чаще всего ссылаются внешние ресурсы. Левая диаграмма показывает, что большинство ссылок ведут на страницы категорий. Но глядя на правую диаграмму можно заметить, что общее количество качественных бэклинков не больше ста. Здесь напрашивается вывод о том, что нужно эффективно перенаправлять внутренний ссылочный вес со страниц категорий на приоритетные страницы и наращивать качественную ссылочную массу.

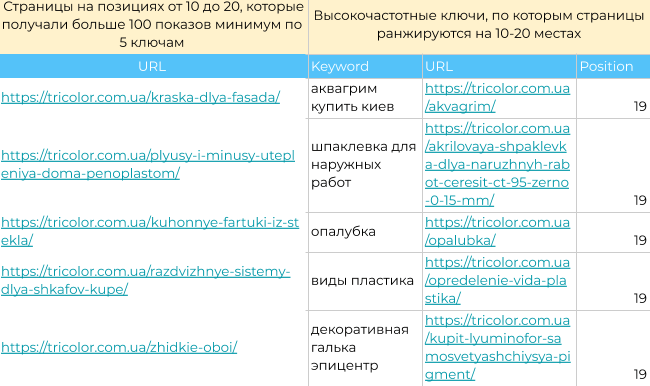

Находим с помощью формул точки роста проекта. Например, в моём случае — это страницы и ключи, которые нужно дооптимизировать для вывода в топ.

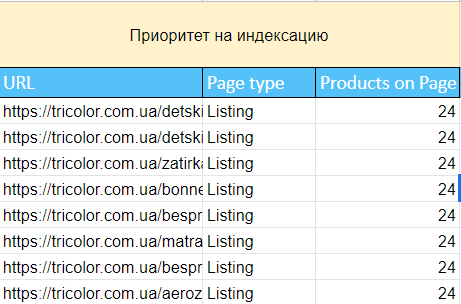

Для работы с непроиндексированными страницами я использовал сортировку по принципу: сначала листинги с наибольшим количеством товаров (так как они чаще всего являются страницей входа на пути к конверсии на этом проекте), а после них сами карточки.

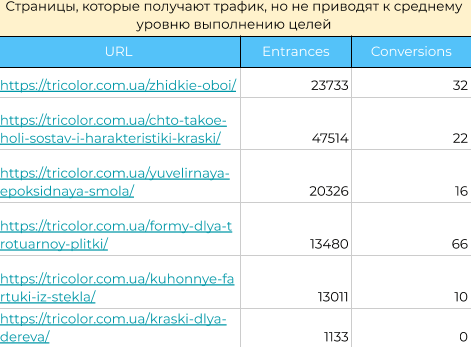

Выгружаю страницы с хорошими показателями трафика и низкими показателями конверсий и начинаю заниматься их оптимизацией. Здесь уже происходит работа не только по поисковой оптимизации, но и по оптимизации конверсий (CRO).

Итак, мы получили данные и диаграммы, демонстрирующие реальные проблемы на сайте. Их можно показать клиенту и в таком виде, а можно для презентабельности визуализировать отчёты в Google Data Studio.

Читайте также: «Что такое дашборд, и как его создать в Google Data Studio».

5. Нюансы, которые важно учитывать

Каждый отдельный проект имеет свои нюансы, поэтому мой шаблон SOP необходимо кастомизировать с учётом того, что:

- Определять тип страницы / категории не всегда можно по URL. Нужно использовать парсинг по элементам на странице (schema, хлебные крошки, куски кода).

- Могут быть смешанные данные в сервисах по http и https-протоколам. Показатели необходимо склеивать.

- Если старые бэклинки ведут на HTTP версию сайта, а вы переехали на HTTPS, тоже нужно склеивать.

- Категории по количеству слов, внутренних ссылок определяются индивидуально для проекта.

- Для каждого проекта нужно сделать шаблон регулярного выражения, который будет определять брендовость запроса.

- Проще анализировать сайт с историей, у него больше данных, и это позволяет лучше ориентироваться в ситуации.

- Если вы работаете с большими проектами (более 30 тысяч страниц), вы столкнётесь с ограничением в 5 миллионов ячеек таблицы, поэтому для агрегации Google Таблицах и Excel (более 50-70 тысяч страниц) не подойдут.

А ещё наш Product Marketing Manager Костя Баньковский написал пост и снял видео о том, как настроить краулер Netpeak Spider, чтобы найти нестандартные SEO-ошибки на сайте:

Подводим итоги

С помощью алгоритма сбора данных, который я описал в этом посте, вы сможете проводить комплексный анализ данных, проверять сайт на SEO-ошибки, находить реальные проблемы и точки роста. Все данные можно визуализировать и показать клиенту.

Используйте мой шаблон и делитесь фидбеком 🙂

Источник https://netpeak.net/ru/blog/seo-audit-sayta-v-2023-kakim-dolzhen-byt/

Источник https://netpeaksoftware.com/ru/blog/how-to-check-website-for-seo-errors-and-find-traffic-growth-opportunities-step-by-step-guide